Линейные модели

В предыдущих главах мы изучили применение метода линейной регрессии для предсказания непрерывной целевой переменной и логистической регрессии для решения задач классификации. Можно заметить, что по сути это одна и та же модель, но немного по-другому использующаяся при решении разных задач. В основе обеих этих моделей лежит использование линейной функции. Мы подбираем параметры этой линейной функции таким образом, чтобы она удовлетворяла определенным оптимизационным критериям. И вот сами эти критерии различаются для задач регрессии и классификации.

И в той и в другой задаче мы имеем обучающую выборку, которую можно представить как некоторое множество точек в многомерном пространстве. Причем, в задачах регрессии мы обычно воспринимаем целевую переменную как еще одно измерение. Поэтому на двумерных графиках мы часто изображаем регрессию от одной переменной (то есть с одним атрибутом x, одной колонкой в наборе данных) - вместе с целевой переменной получится как раз два измерения. А вот в задачах классификации значения целевой переменной, то есть класс объекта, обычно не воспринимается как отдельное измерение, а как некоторая встроенная характеристика точки. Поэтому мы можем легко изобразить на двумерном графике задачу классификации на двух признаках ($x_1$ и $x_2$) - ведь метку класса мы изображаем как цвет или форму точки.

Но помните, как в начале прошлой части учебника мы пытались изобразить классификацию также как регрессию - откладывая целевую переменную по одной из осей? На самом деле размерность задачи определяется только количеством признаков, независимо от того, какую задачу мы решаем. Если у нас один признак - то мы имеем распределение точек на плоскости. Если два - в пространстве, а если больше - в гиперпространстве. Представить это становится все труднее, поэтому мы учимся на примерах маленькой размерности. Важно понять, как устроены модели и методы, а математический аппарат способен обобщить наши подходы на произвольное количество измерений.

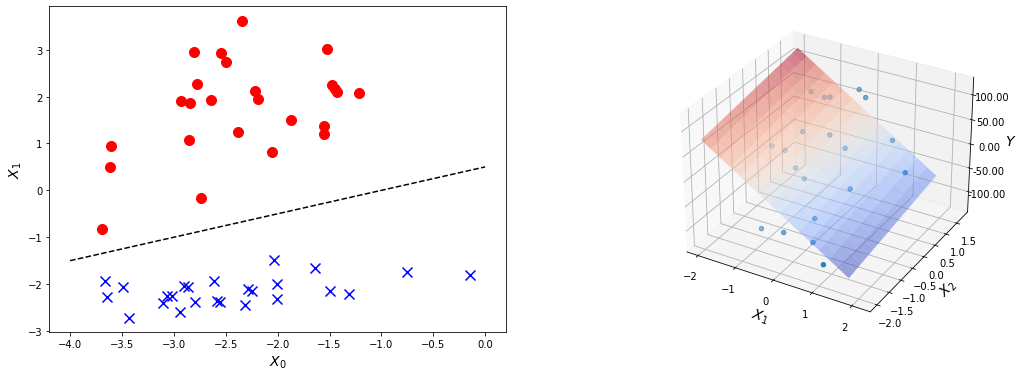

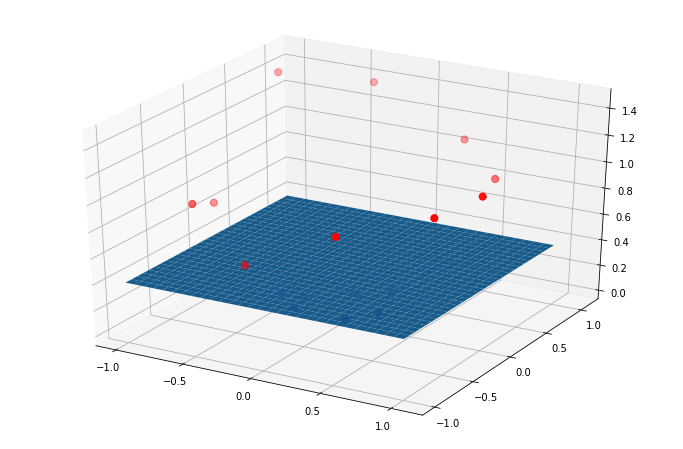

А линейные модели устроены таким образом, что они описывают некоторое линейное подпространство с размерностью, на единицу меньшей, чем размерность всей задачи в целом. Если в модели один признак - то линейная функция будет представлять собой прямую в той плоскости, в которой лежат точки такой двумерной задачи. Если два признака - то плоскость и пространстве трехмерной задачи (как на рисунке ниже). А если признаков больше - то гиперплоскость, вложенную в гиперпространство.

В любом случае мы находим линейную комбинацию координат этих точек с вектором весов, то есть по сути, некоторую гиперплоскость в этом многомерном пространстве. Однако то, какая именно линейная комбинация, будет для нас оптимальной, то есть какие коэффициенты в линейной функции мы хотим получить, зависит от задачи. Если мы решаем задачу регрессии, то мы строим линию таким образом, чтобы она лучше всего легла в точки. Причем здесь имеется в виду распределение точек вместе с целевой переменной. Как мы уже изучали, для этого нам нужна функция ошибки. То есть мы сравниваем значение функции гипотезы (модели) с истинными значениями целевой переменной и подбираем параметры модели таким образом, чтобы эти отклонения были как можно меньше.

Немного другая ситуация с классификацией. Линейная модель также формирует гиперплоскость, но на этот раз мы не рассматриваем целевую переменную как еще одно измерение. То есть граница принятия решения должна быть на одно измерение меньше, чем размерность самой задачи. И мы как раз это и видим - для классификации нам не очень важно само значение функции гипотезы, нам важна область точек, в которых она равна 0. Эта область как раз и формирует границу принятия решения.

Логистическая функция здесь нужна только для того, чтобы более надежно реализовать оптимизацию параметров методом градиентного спуска. Для точек, которые лежат по одну сторону границы мы хотим, чтобы линейная функция принимала положительные значения, а, соответственно, логистическая модель - значения, близкие к единице. И мы хотим, чтобы граница принятия решения располагалась таким образом, чтобы по эту сторону от нее располагались те точки, которые в обучающей выборке отнесены к положительному классу.

Другими словами, линейная и логистическая регрессии - суть одна и та же модель, использующаяся в разных условиях и с разными задачами. Поэтому, кстати, логистическая регрессия является линейной моделью. Вообще, стоит говорить об одном классе моделей - линейных моделей - которые применяются как к задачам регрессии, так и к задачам классификации.

Это справедливо и по отношению к другим классам моделей, которые мы будем рассматривать в данной главе. Очень редкие модели можно применять только к задачам классификации или к задачам регрессии. Мы вообще изучим только один такой пример - наивный байесовский классификатор, который по своей сути нельзя применить к регрессионным задачам. А в большинстве совем одни и те же модели могут использоваться для решения как задач предсказания дискретного, так и непрерывного значения.

Поэтому мы не говорим отдельно об алгоритмах классификации или моделях регрессии. Есть модели обучения с учителем. Именно поэтому, кстати, в документации к библиотеке sklearn вы не найдете отдельных частей, посвященных регрессии и классификации. Есть глава, посвященная линейным моделям, методу опорных векторов и так далее. И мы дальше будем изучать модели исходя именно из этой логики.

Так как мы теперь говорим об общем классе линейных моделей, выделим главные их черты, которые отличают в практическом применении их от других видов моделей и алгоритмов машинного обучения. В первую очередь надо сказать, что линейные модели - это самый простой класс моделей. Это свидетельствует не только о примитивности (низкой вариативности) самого класса линейных функций. Главное - что линейные модели достаточно быстро обучаются. Существуют алгоритмы. которые требуют гораздо больших вычислительных мощностей для своей работы. Это несомненное преимущество линейных моделей.

Но из их простоты следует и главный недостаток. Линейные модели могут описать только линейные зависимости в данных. Для задач регрессии это означает, что линейные модели хорошо описывают данные, в которых присутствует линейная корреляция между признаками и целевой переменной. Если же в данных нет корреляции, либо зависимость имеет нелинейный характер, то линейные модели в принципе не способны хорошо (то есть с низкой ошибкой) описать это набор данных. Для задач классификации аналогичное свойство - линейная разделимость. Если граница между разными классами носит явно нелинейный характер, то логистическая регрессия просто не справится с разделением данных по классам.

Надо помнить, что линейные зависимости в данных не означает, что данные точно описываются линейной функцией. Бывают ситуации, когда данные может быть формально и не являются линейно неразделимыми (в случае с классификацией) или не лежат на одной прямой (для регрессии), но явно демонстрируют линейную зависимость. Ведь мы строим модель, чтобы она научилась выявлять общие зависимости в данных, но в них часто есть и случайные колебания, которые не должны влиять на результат моделирования.

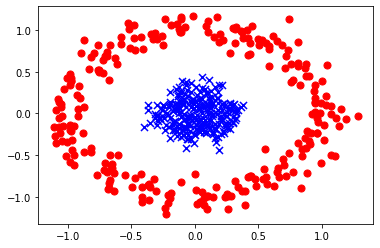

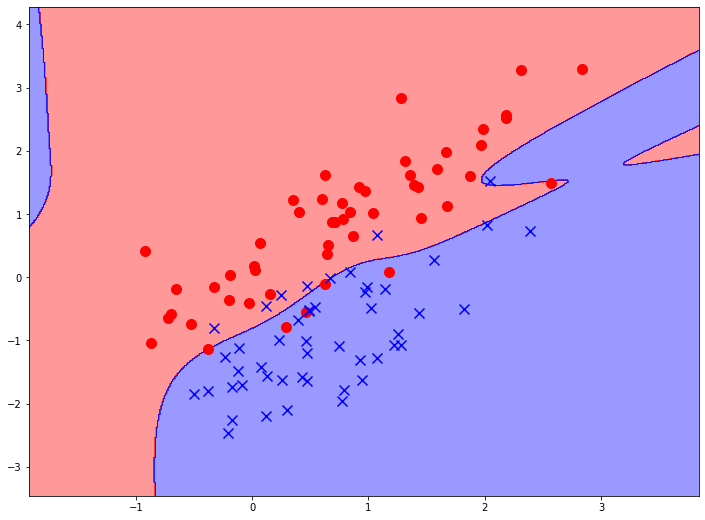

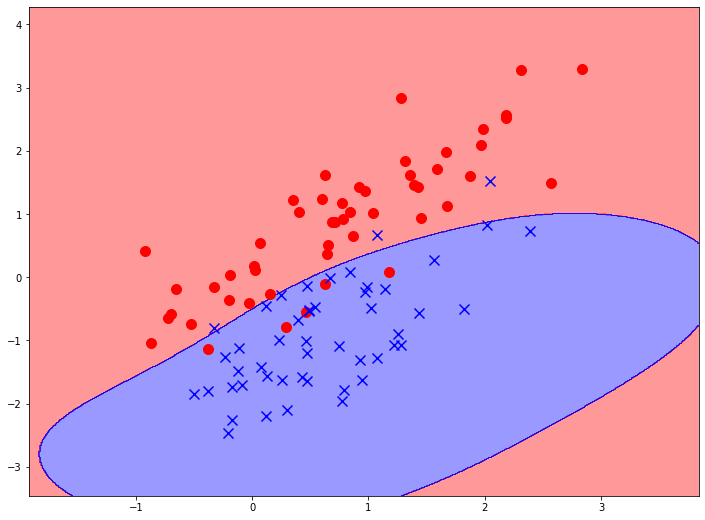

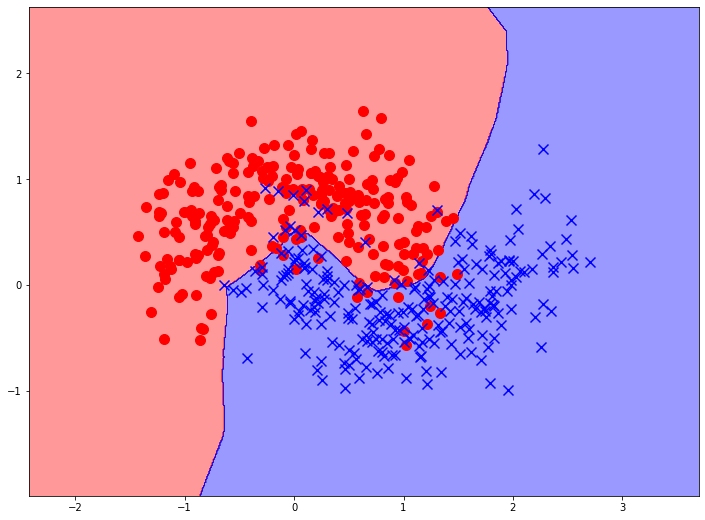

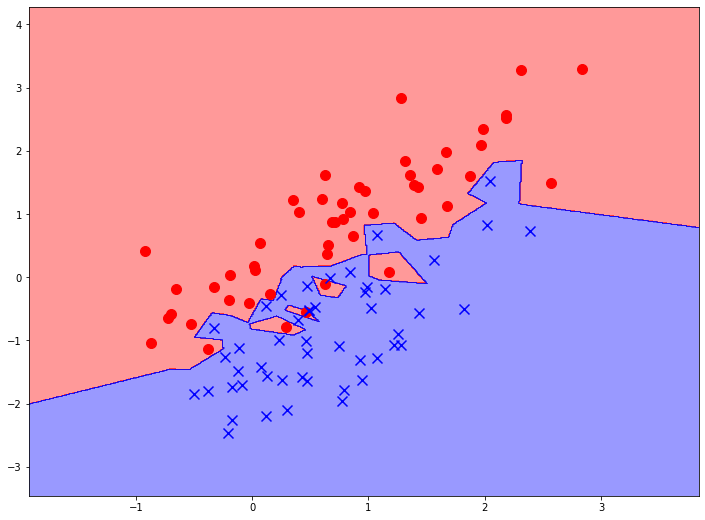

Сравните, например, такую картинку со следующей. На обоих изображены линейно неразделимые наборы данных. Но мы совершенно правильно интуитивно понимаем, что на верхнем графике изображены данные, которые очень хорошо будут описаны линейной моделью. И неважно, что несколько точек мы классифицируем неправильно. Даже наоборот, было бы хуже пытаться построить модель, которая бы учитывала эти аномальные точки и строила бы очень сложную границу принятия решений.

Еще одно достоинство, общее для линейных моделей - их интерпретируемость. Параметрами линейных моделей являются коэффициенты при признаках (плюс еще свободный коэффициент). И в любой реальной задаче признаки имеют какую-то интерпретацию, физический смысл. Поэтому их коэффициенты тоже можно объяснить в терминах предметной области. Коэффициент каждого признака показывает, на сколько изменится значение целевой переменной при изменении данного признака на единицу. То есть коэффициент косвенно показывает силу связи признака и целевой переменной. Если признак не влияет на нее, то его коэффициент будет стремиться к нулю. А свободный параметр показывает уровень целевой переменной при нулевых значениях признака.

Интерпретируемость модели машинного обучения - это очень важная характеристика, особенно в некоторых серах применения, например, в медицинской диагностике, государственном управлении, социальной сфере. В таких предметных областях нужно не просто строить качественные модели, но и уметь объяснять их предсказания, понимать, почему и за счет чего было принято такое решение. Поэтому при прочих равных более интерпретируемая модель всегда будет предпочтительнее.

Выводы:

- Линейные модели могут служить как моделями классификации, так и моделями регрессии.

- По сути, это одна модель, которую приспосабливают для решения разных задач.

- Линейная модель - это результат вычисления линейной комбинации признаков и параметров: $ h_b (x) = X \cdot \vec{b} $

- Для задач регрессии мы сравниваем результат $ X \cdot \vec{b} $ с $ y $.

- Для задач классификации мы строим разделяющее множество $ X \cdot \vec{b} = 0 $.

- Эффективность линейных моделей зависит от структуры данных (для регрессии это должна быть линейная корреляция, для классификации - линейная разделимость).

- Линейные модели достаточно просты в обработке, но склонны к недообучению из-за своей простоты.

- Линейные модели интерпретируемы - их коэффициентам можно придать физический смысл.

Полиномиальные модели

Линейные модели обладают неоспоримыми достоинствами, когда мы имеем дело с датасетом определенной структуры. Например, на графике выше представлен очевидно линейно разделимый датасет. И при его анализе более сложные модели даже и не нужны, со всем справится простая логистическая регрессия.

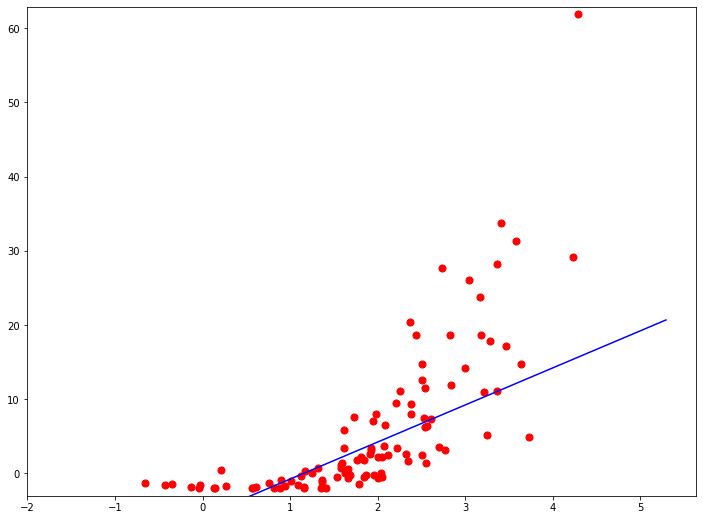

Полиномиальная регрессия

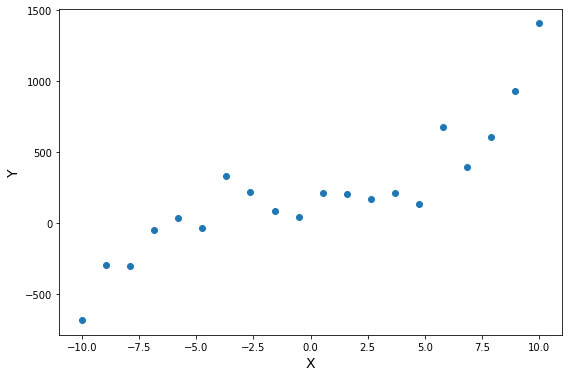

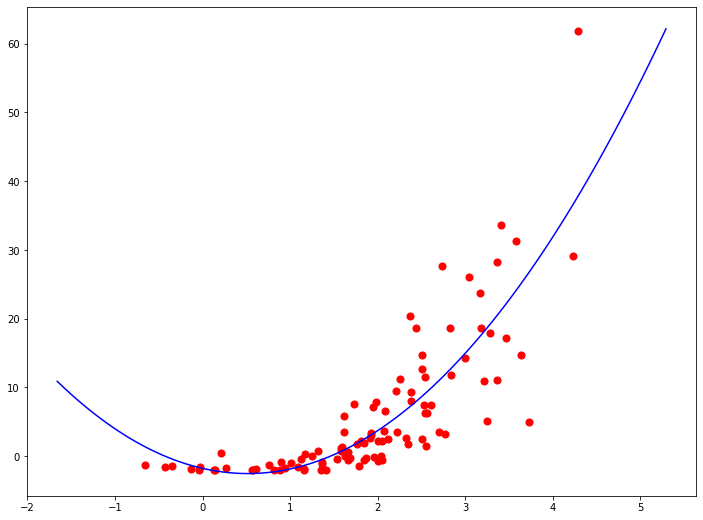

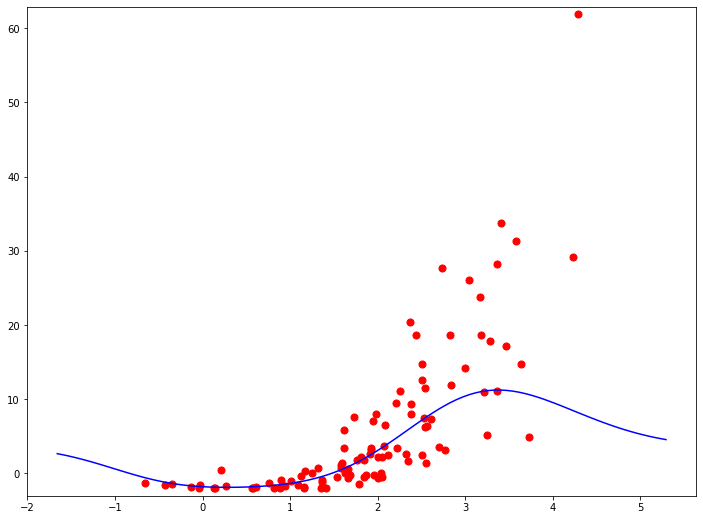

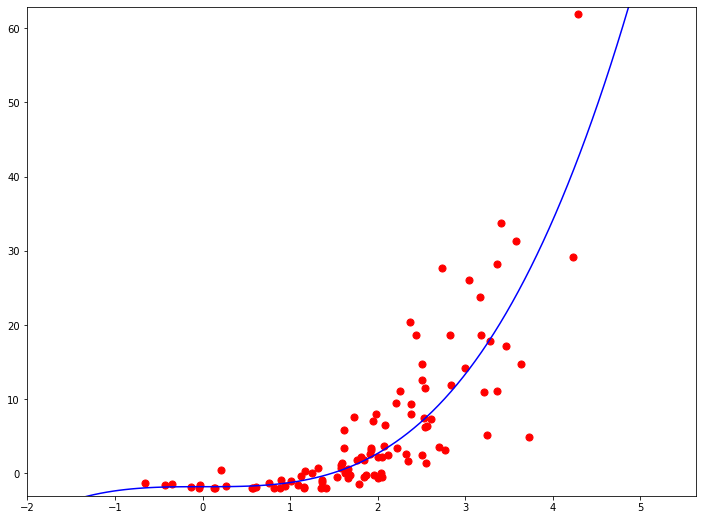

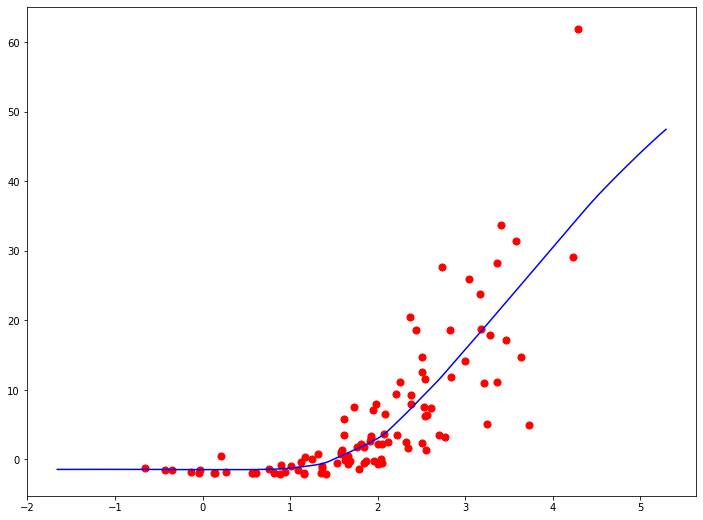

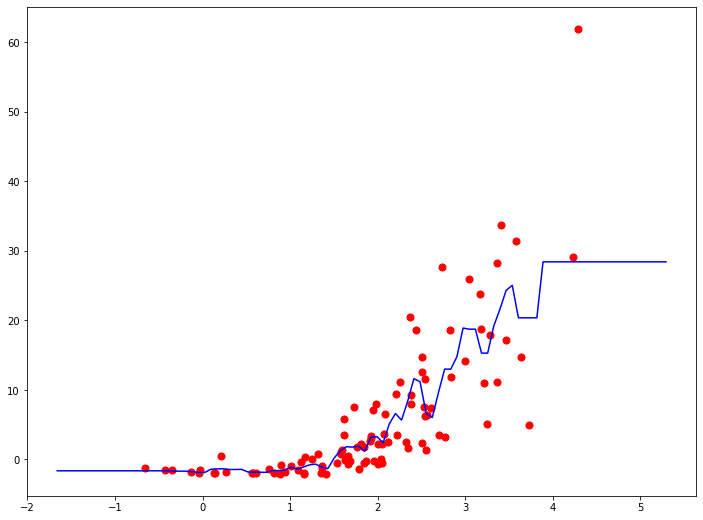

Функция гипотезы не обязательно должна быть линейной, если это не соответствует данным. На практике вы не всегда будете иметь данные, которые можно хорошо аппроксимировать линейной функцией. Наглядный пример вы видите на иллюстрации. Вполне очевидно, что в среднем увеличение целевой переменной замедляется с ростом входной переменной. Это значит, что данные демонстрируют нелинейную динамику. И это так же значит, что мы никак не сможем их хорошо приблизить линейной моделью.

Надо подчеркнуть, что это не свидетельствует о несовершенстве наших методов оптимизации. Мы действительно можем найти самую лучшую линейную функцию для данных точек, но проблема в том, что мы всегда выбираем лучшую функцию из некоторого класса функций, в данном случае - линейных. То есть проблема не в алгоритмах оптимизации, а в ограничении самого вида модели.

вполне логично предположить, что для описания таких нелинейных наборов данных следует использовать нелинейные же функции моделей. Но очень бы не хотелось, для каждого нового класса функций изобретать собственный метод оптимизации, поэтому мы постараемся максимально “переиспользовать” те подходы, которые описали выше. И механизм множественной регрессии в этом сильно поможет.

Мы можем изменить поведение или кривую нашей функции гипотезы, сделав ее квадратичной, кубической или любой другой формой.

Например, если наша функция гипотезы $ \hat{y} = h_b (x) = b_0 + b_1 x $, то мы можем добавить еще один признак, основанный на $ x_1 $, получив квадратичную функцию

или кубическую функцию

В кубической функции мы по сути ввели два новых признака: $ x_2 = x^2, x_3 = x^3 $. Точно таким же образом, мы можем создать, например, такую функцию:

В любом случае, мы из парной линейной функции сделали какую-то другую функцию. И к этой нелинейной функции можно относиться по разному. С одной стороны, это другой класс функций, который обладает нелинейным поведением, а следовательно, может описывать более сложные зависимости в данных. С другой стороны, это линейна функция от нескольких переменных. Только сами эти переменные оказываются в функциональной зависимости друг от друга. Но никто не говорил, что признаки должны быть независимы.

И вот такое представление нелинейной функции как множественной линейной позволяет нам без изменений воспользоваться алгоритмом градиентного спуска для множественной линейной регрессии. Только вместо $ x_2, x_3, … , x_n $ нам нужно будет подставить соответствующие функции от $ x_1 $.

Очевидно, что нелинейных функций можно придумать бесконечное количество. Поэтому встает вопрос, как выбрать нужный класс функций для решения конкретной задачи. В случае парной регрессии мы можем взглянув на график точек обучающей выборки сделать предположение о том, какой вид нелинейной зависимости связывает входную и целевую переменные. Но если у нас множество признаков, просто так проанализировать график нам не удастся. Поэтому по умолчанию используют полиномиальную регрессию, когда в модель добавляют входные переменные второго, третьего, четвертого и так далее порядков.

Порядок полиномиальной регрессии подбирается в качестве компромисса между качеством получаемой регрессии, и вычислительной сложностью. Ведь чем выше порядок полинома, тем более сложные зависимости он может аппроксимировать. И вообще, чем выше степень полинома, тем меньше будет ошибка при прочих равных. Если степень полинома на единицу меньше количества точек - ошибка будет нулевая. Но одновременно с этим, чем выше степень полинома, тем больше в модели параметров, тем она сложнее и занимает больше времени на обучение. Есть еще вопросы переобучения, но про это мы поговорим позднее.

А что делать, если изначально в модели было несколько признаков? Тогда обычно для определенной степени полинома берутся все возможные комбинации признаком соответствующей степени и ниже. Например:

Для регрессии с двумя признаками.

Линейная модель (полином степени 1):

\[h_b (x) = b_0 + b_1 x_1 + b_2 x_2\]Квадратичная модель (полином степени 2):

\[h_b (x) = b_0 + b_1 x + b_2 x_2 + b_3 x_1^2 + b_4 x_2^2 + b_5 x_1 x_2\]Кубическая модель (полином степени 3):

\[\hat{y} = h_b (x) = b_0 + b_1 x_1 + b_2 x_2 + \\ + b_3 x_1^2 + b_4 x_2^2 + b_5 x_1 x_2 + \\ + b_6 x_1^3 + b_7 x_2^3 + b_7 x_1^2 x_2 + b_8 x_1 x_2^2\]При этом количество признаков и, соответственно, количество параметров растет экспоненциально с ростом степени полинома. Поэтому полиномиальные модели обычно очень затратные в обучении при больших степенях. Но полиномы высоких степеней более универсальны и могут аппроксимировать более сложные данные лучше и точнее.

Выводы:

- Данные в датасете не всегда располагаются так, что их хорошо может описывать линейная функция.

- Для описания нелинейных зависимостей нужна более сложная, нелинейная модель.

- Чтобы не изобретать алгоритм обучения заново, можно просто ввести в модель суррогатные признаки.

- Суррогатный признак - это новый признак, который считается из существующих атрибутов.

- Чаще всего используют полиномиальную регрессию - это когда в модель вводят полиномиальные признаки - степени существующих атрибутов.

- Обычно берут все комбинации факторов до какой-то определенной степени полинома.

- Полиномиальная регрессия может аппроксимировать любую функцию, нужно только подобрать степень полинома.

- Чем больше степень полиномиальной регрессии, тем она сложнее и универсальнее, но вычислительно сложнее (экспоненциально).

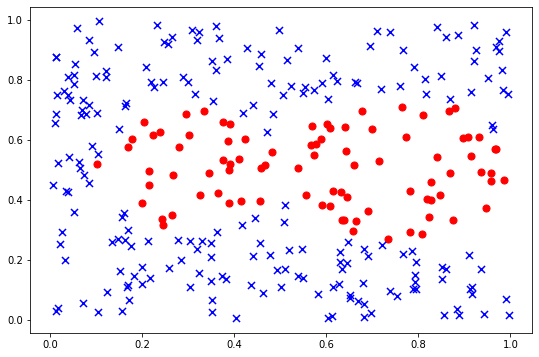

Полиномиальная классификация

Напомним, как выглядит функция модели:

Эта самая простая модель показывает себя хорошо даже и во многих реальных задачах. Особенно если в датасете собрано множестве признаков, есть неплохой шанс на появление линейных связей в данных. Во всяком случае, линейную модель стоит протестировать одной из первых.

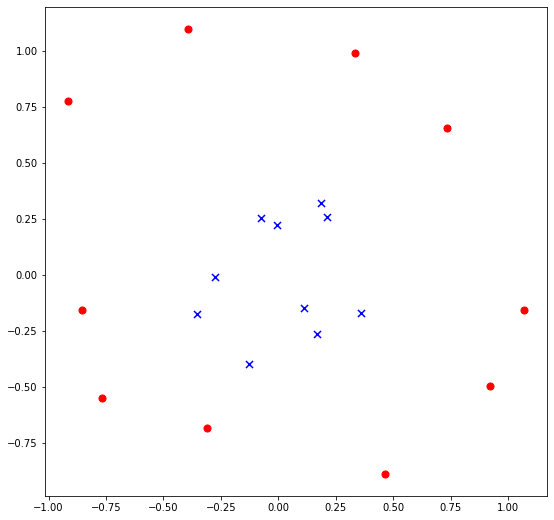

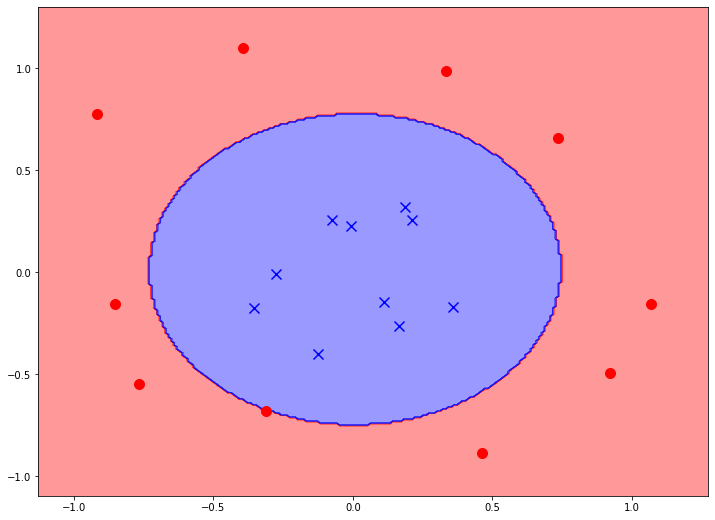

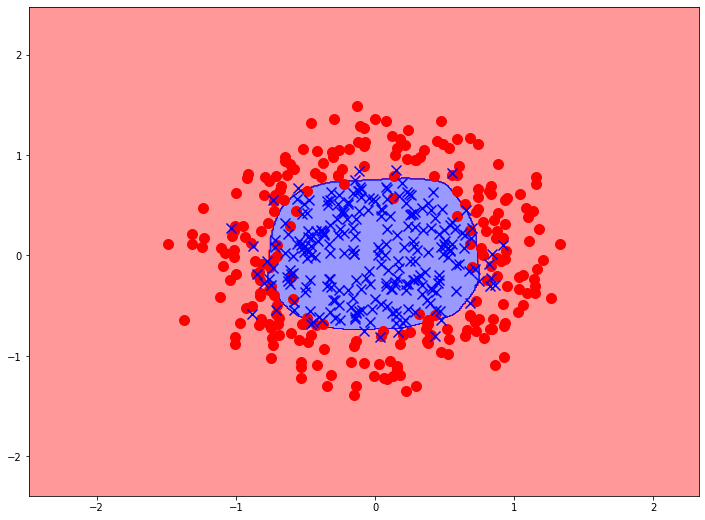

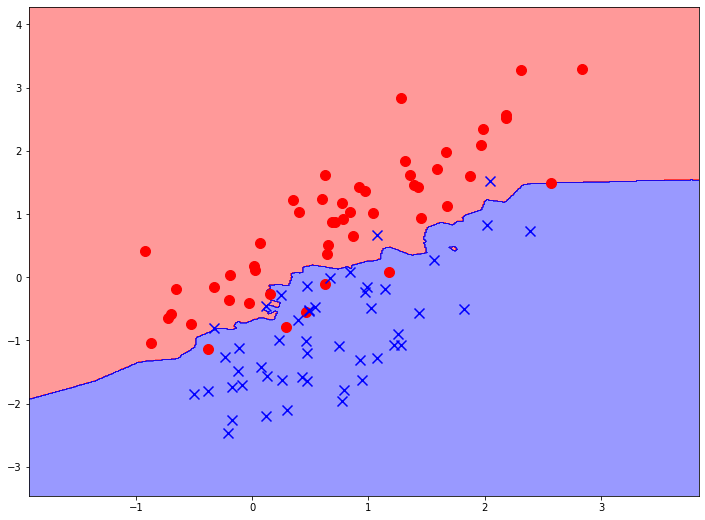

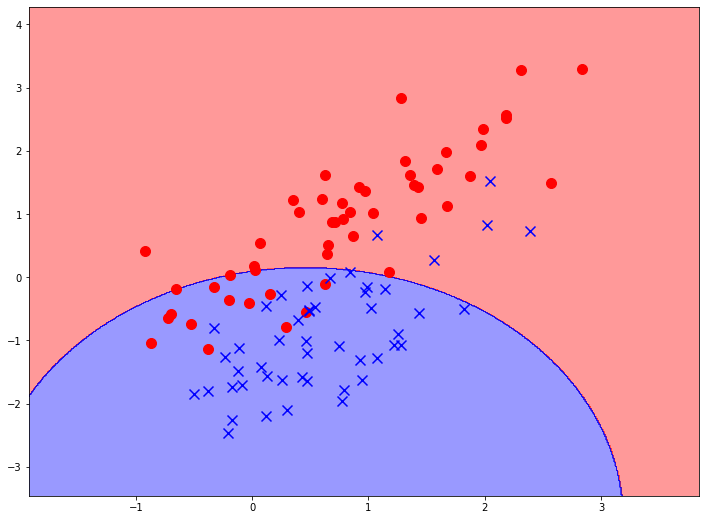

Но зачастую мы имеем такие данные, которые просто не могут быть описаны линейной моделью. В таком случае, стоит строить более сложные модели. Мы уже говорили о полиномиальных моделях для задач регрессии. Но они с равным успехом могут применяться и для классификации. Рассмотрим, например, такой набор данных.

Здесь тоже очень четко прослеживается граница между двумя классами, то есть потенциальная граница принятия решения. Только очевидно, что она носит не линейный характер. Для того, чтобы построить такую границу нам можно взять более сложную функцию, содержащую признаки во второй степени (так как мы подозреваем, что граница принятия решений является кривой второго порядка). Например, возьмем такую функцию:

Конечно, когда в наборе данных больше двух признаков, такие простые графики не получится построить. Поэтому очень сложно заранее сказать, есть ли преобладающая линейная зависимость или данные описываются нелинейными моделями. Здесь мы рисуем эти графики, чтобы показать, как устроены и как работают модели. Они не используются для подбора моделей. Это вообще зачастую выбор “вслепую”.

Мы говорили, что полиномиальную модель можно рассматривать двумя способами - как модель более сложного класса и как добавление новых признаков к набору данных и, таким образом, переход в пространство боле высокой размерности. Рассмотрим простой пример. Выведем на печать матрицу признаков с графика выше:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

array([[-0.31, -0.68],

[ 0.36, -0.17],

[ 0.17, -0.26],

[-0.07, 0.26],

[-0.85, -0.16],

[-0.13, -0.4 ],

[ 0.11, -0.15],

[ 0.19, 0.32],

[-0.77, -0.55],

[-0.01, 0.22],

[ 0.73, 0.66],

[ 0.33, 0.99],

[ 0.21, 0.26],

[-0.39, 1.1 ],

[ 0.46, -0.89],

[ 1.07, -0.16],

[-0.35, -0.18],

[-0.92, 0.77],

[-0.27, -0.01],

[ 0.92, -0.5 ]])

Анализируя график можно заметить, что синие точки (положительный класс) сосредоточены ближе к началу координат, а красные - дальше от него. Расстояние от начала координат для каждой точки можно вычислить как сумму квадратов ее координат. Давайте добавим в матрицу третий столбец - еще один признак - сумму квадратов первых двух признаков:

1

X1 = np.append(X, (X[:, 0] ** 2 + X[:, 1] ** 2).reshape((-1, 1)), axis=1)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

array([[-0.31, -0.68, 0.56],

[ 0.36, -0.17, 0.16],

[ 0.17, -0.26, 0.1 ],

[-0.07, 0.26, 0.07],

[-0.85, -0.16, 0.75],

[-0.13, -0.4 , 0.18],

[ 0.11, -0.15, 0.03],

[ 0.19, 0.32, 0.14],

[-0.77, -0.55, 0.89],

[-0.01, 0.22, 0.05],

[ 0.73, 0.66, 0.97],

[ 0.33, 0.99, 1.09],

[ 0.21, 0.26, 0.11],

[-0.39, 1.1 , 1.36],

[ 0.46, -0.89, 1. ],

[ 1.07, -0.16, 1.17],

[-0.35, -0.18, 0.16],

[-0.92, 0.77, 1.44],

[-0.27, -0.01, 0.08],

[ 0.92, -0.5 , 1.09]])

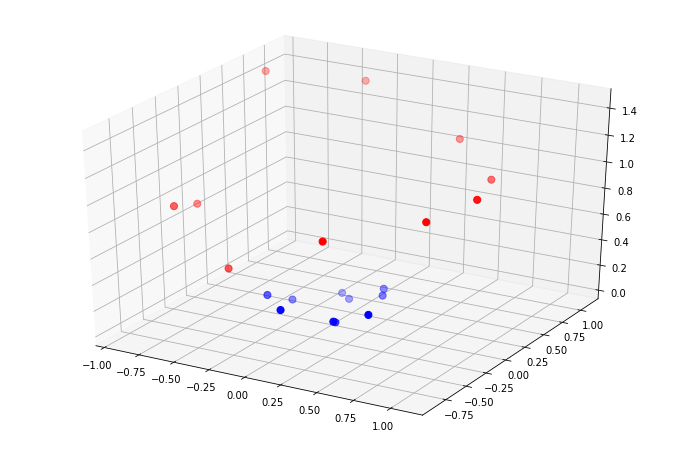

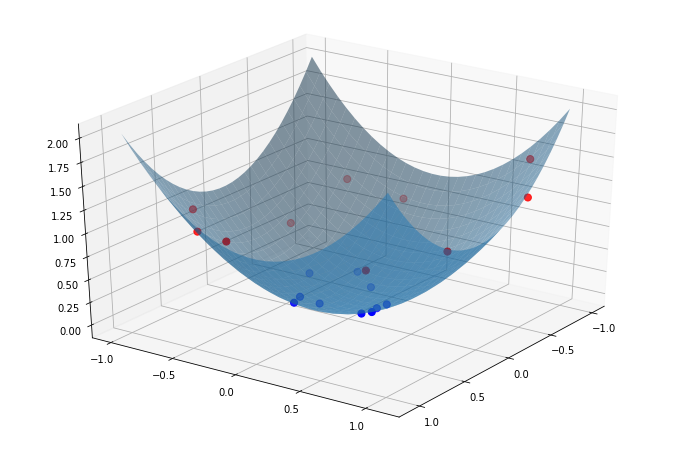

Целевую переменную мы, конечно, не трогаем. Давайте посмотрим на трехмерный график - расположение этих точек в пространстве более высокой размерности:

Мы видим, что за счет введения третьего признака набор данных стал очень даже линейно разделимым. Теперь синие точки располагаются ниже красных и их можно отделить плоскостью. В данном конкретном случае, плоскость будет горизонтальна, то есть при разделении мы будем использовать вообще только третий признак. В общем случае это не выполняется. Важно, что точки стали располагаться так, что их теперь можно будет разделить, например, вот так:

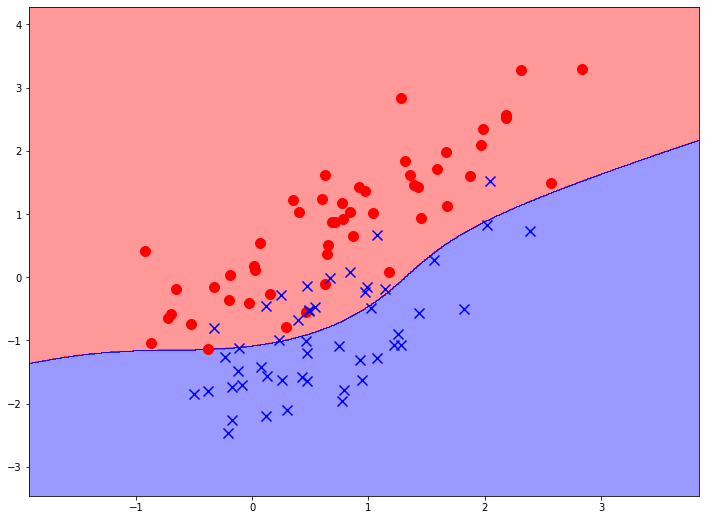

То есть после добавления полиномиального признака мы используем обычную линейную модель, но в надпространстве. Откуда же берутся нелинейные границы принятия решений? Это происходит когда мы пытаемся изобразить эту границу в изначальном двумерном пространстве. Ведь изначальная плоскость двумерного графика в этом трехмерном пространстве будет представляться поверхностью второго порядка вот так:

Пересечение этой поверхности с нашей плоскостью принятия решения как раз и формирует границу, которую модель строит на двумерном графике. Получается кривая второго порядка. Она может выглядеть примерно так:

На этом примере мы, кстати, можем видеть, почему так труден анализ многомерных данных. Наш изначальный двумерный график с точками по сути своей представляет собой проекцию трехмерного графика на горизонтальную плоскость. Когда мы изображаем два каких-то признака из множества, мы всегда берем проекцию. Так вот, в трехмерном графике абсолютно очевидна линейная разделимость данных. Однако, когда мы анализируем проекцию, данные становятся как бы “вперемешку”. Поэтому по проекции нельзя судить о наличии или отсутствии структуры в данных.

На практике мы не можем знать, какой именно искусственный признак даст нам разделимость выборки в пространстве более высокой размерности. Поэтому обычно добавляют все возможные комбинации всех признаков до определенной степени полинома. В данном случае, для получения полинома второй степени нам нужно было еще добавить признаки $x_1^2$ и $x_2^2$. Они бы не очень влияли на расположение границы принятия решений, но линейные модели могут справится с “лишними” признаками в данных - коэффициенты при них будут просто близкими к нулю.

Но в общем случае, могут использоваться все признаки в полиноме. Если у нас два изначальных атрибута и мы строим полином второй степени, то у нас получится пять признаков в модели - $x_1, x_2, x_1^2, x_2^2, x_x x_2$. Тогда граница принятия решений может быть любой кривой второго порядка. А может быть и так:

Ведь граница принятия решения - это по сути область пересечения гиперплоскости с поверхностью второго порядка. Это пересечение может иметь и более сложную форму.

Конечно, при работе с библиотечными функциями не придется руками перебирать все возможные полиномиальные комбинации. Поэтому достаточно легко можно построить полиномиальную классификацию, например, 10-го порядка:

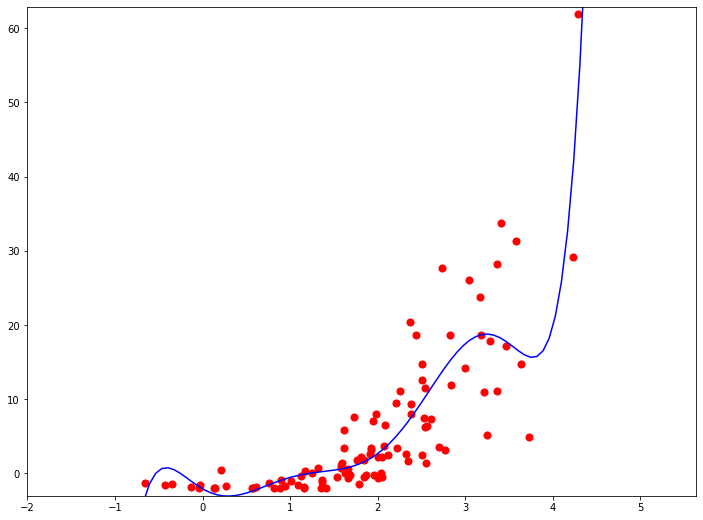

Она уже выглядит гораздо более сложной. За счет того, что она содержит гораздо больше признаков, она более вариабельна, и поэтому способна улавливать более сложные зависимости в данных и строить более сложные границы принятия решений.

Естественно, если мы представляем полиномиальные модели как модификацию исходного набора данных, а именно - добавление к нему новых признаков, то ничего не мешает применять этот пример как для регрессионных, так и для классификационных задач. Ниже вы видите пример полиномиальной модели регрессии со степенью полинома 2:

А на следующем графике - степень выросла до 7.Обратите внимание, насколько более сложной стала функция модели. Но в данном конкретном примере она все равно далека от того, чтобы пройти точно через все точки.

Здесь и далее мы уже будем употреблять термины “атрибут” и “признак” более точно. Раньше для нас это были синонимы. Так и есть при рассмотрении линейных моделей. Но, срого говоря, атрибут - это характеристика объекта реального мира. Оно зафиксировано в наборе данных и каждый атрибут обладает определенным смыслом в предметной области. Признак - это вектор, который подается на вход модели машинного обучения. Мы можем использовать как признаки сами атрибуты. Можем создавать новые признаки на основе существующих атрибутов. Можем удалять атрибуты из данных, так что они не становятся признаками. А можем модифицировать атрибут (например, нормировать его) и он превратится в другой признак.

Полиномиальные модели как для регрессии, так и для классификации - это универсальные аппроксиматоры. Ведь полиномом достаточно большой степени можно приблизить любую функцию. Этим, кстати и занимаются ряды Тейлора в математическом анализе. Поэтому с помощью полиномиальных моделей мы может решать задачи любой сложности. Однако, при высоких степенях полиномиальные модели могут быть не очень эффективны. Ведь количество признаков экспоненциально растет при увеличении степени. Если у нас изначально было два атрибута, то для второй степени получится, как мы уже считали, пять признаков, для третьей - 11, а для четвертой - уже 21. Но если изначально у нас было больше атрибутов, например, 10, то все еще хуже. Для второй степени понадобится 55 признаков, а для третьей - больше 500. В целом количество признаков растет экспоненциально. Так что если у вас изначально многопризнаков или задача очень сложная, то полиномиальные модели будут работать очень медленно.

Выводы:

- Добавление полиномиальных признаков возможно как к регрессионным, так и к классификационным моделям.

- Полиномиальная регрессия позволяет охватывать нелинейные зависимости атрибутов и целевой переменной.

- Полиномиальная классификация позволяет очерчивать нелинейные границы принятия решений.

- Здесь и далее: атрибуты - характеристики объектов, данные в датасете; признаки - компоненты вектора, подающегося на вход модели машинного обучения.

- Полиномиальные модели универсальны, но очень дороги при высоких порядках полинома.

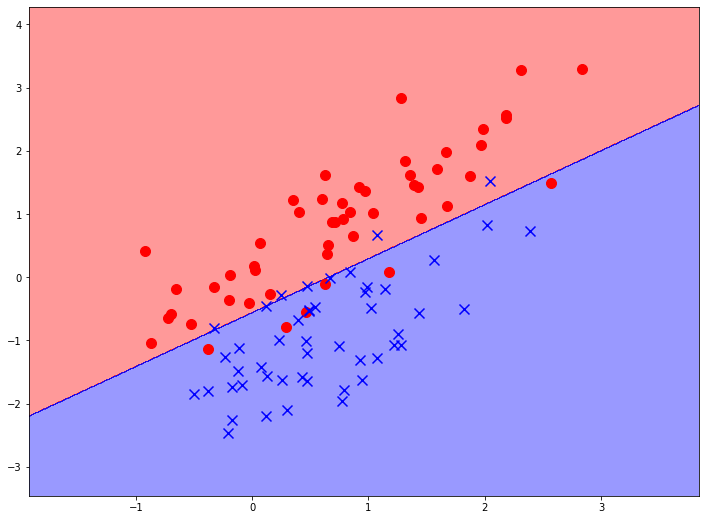

Метод опорных векторов

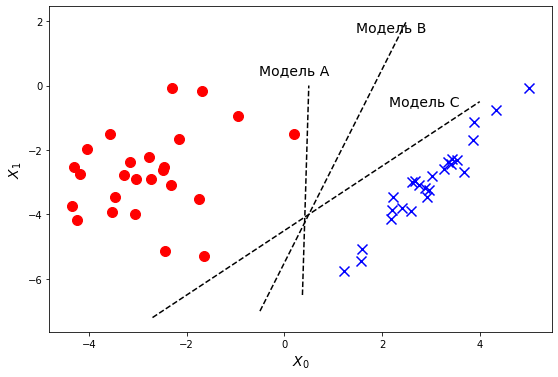

Вернемся на время к случаю линейно разделимых данных для задач классификации. Как мы знаем, для проведения классификации таких данных достаточно линейной модели. В случае линейно разделимых данных логистическая регрессия ищет какую-нибудь разделяющую гиперплоскость. Главное условие - чтобы точки разных классов оказались по разные стороны этой границы. На графике мы видим пример:

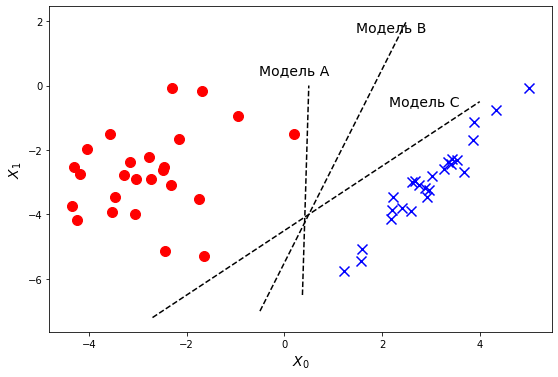

Очевидно, что в случае такого расположения точек данных можно провести несколько разделяющих прямых. Каждая их них соответствует модели классификации. И у каждой из них будет ошибка, почти равная нулю, ведь они все разделяют данные идеально. Но при взгляде на такой график любому становится очевидно, что одна из разделяющих линий предпочтительнее других. Как вы думаете, какая?

Большинство людей ответит, что вторая. Однако, сложнее объяснить, почему мы так думаем. С формальной точки зрения, между ними нет никакой разницы, ведь они все дают нулевую ошибку. Но первая и третья линии проходят подозрительно близко к точкам одной из групп. Почему мы интуитивно считаем, что это плохо.

Следует всегда помнить, что задача модели машинного обучение - не предсказание правильного ответа для обучающей выборки. Мы его и так знаем. Но на примере этой выборки модель должна выявить зависимости в данных, которые позволят классифицировать объекты новые, которых модель еще не видела. Это свойство моделей называется обобщающей способностью. Об этом мы еще поговорим дальше.

Возьмем, например, первую линию. Она прекрасно разделяет те точки, которые мы видим. Но если заставить эту модель классифицировать точку, которая отстоит немного влево от основной группы синих точек, она может дать сбой. Пока мы просто предполагаем такой случай. Позже мы научимся формально его описывать и исключать.

Поэтому чем ближе граница принятия решений к середине между группами точек, принадлежащих разным классам, чем дальше она от самих этих групп, тем надежнее выглядят предсказания данной модели. Это не имеет непосредственного отношения к измерению эффективности моделей, но придает нам уверенность в результативности и обобщающей способности модели.

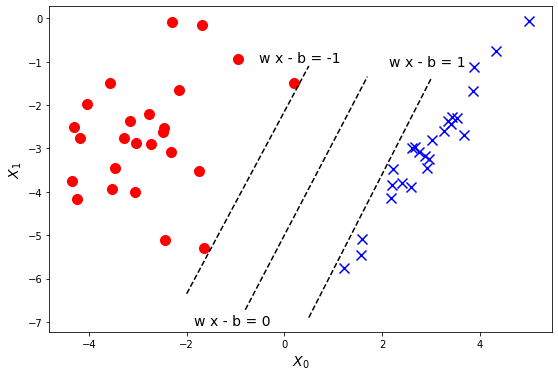

Это расстояние между границей принятия решения и крайними точками выборки, принадлежащими разным классам называется зазором между границей и точками. Можно поставить задачу нахождения разделяющей гиперплоскости максимального зазора. То есть из всех границ принятия решений мы будем выбирать лучшую, ориентируясь не только на значение логарифмической функции ошибки, но и на величину зазора.

Опять, как и раньше мы начнем с модификации уже известного нам алгоритма логистической регрессии. А модифицировать его мы будем так, чтобы он максимизировал зазор между границей и точками. Для этого мы модифицируем функцию ошибки таким образом, чтобы

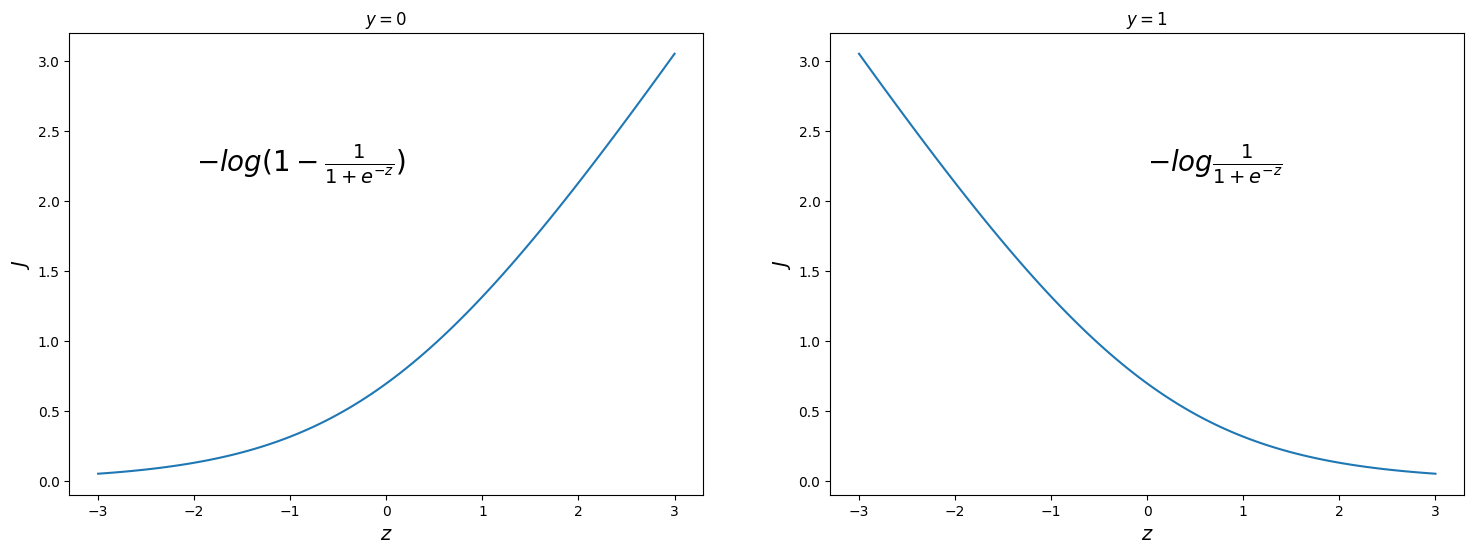

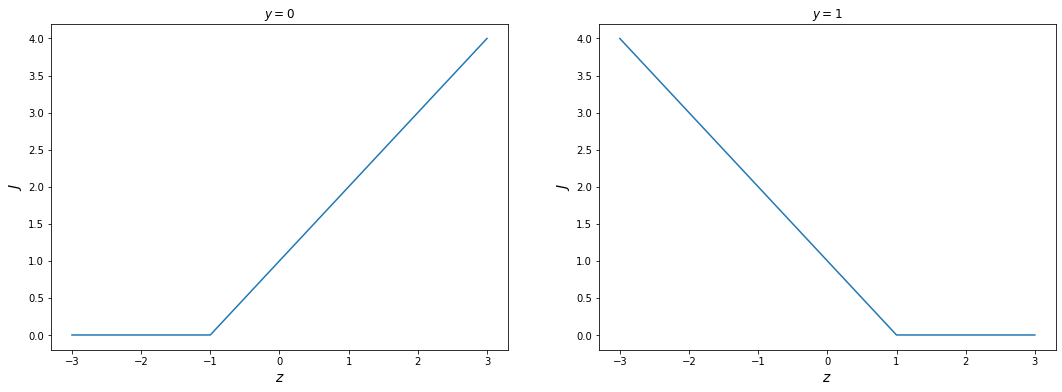

Раньше, в классической модели логистической регрессии, ошибка плавно уменьшалась при стремлении значения линейной комбинации (до передачи в логистическую функцию) в правильную бесконечность. То есть, если реальное значение $y$ у данной точки - 0 (правый график), то есть точка принадлежит отрицательному классу, то чем меньше значение $z$, тем ближе ошибка в данной точке к нулю. При росте $z$ - ошибка неограниченно растет до бесконечности. Если же истинное значение $y = 1$ (левый график), то есть данная точка принадлежит положительному классу, то все наоборот - чем больше $z$, тем ближе ошибка к нулю. Помните, что формулировка функции ошибки - это наша цель оптимизации. То есть, используя именно эту функцию ошибки мы “заставляем” модель принимать правильные значения. И, что важнее, “штрафуем” ошибки. Причем, величина штрафа плавно увеличивается при увеличении степени ошибки.

Однако, если мы хотим принять во внимание зазор, то мы должны усилить формулировку функции ошибки. В частности, мы вообще не будем штрафовать значения $z$, которые дают предсказания, близкие к истинному значению целевой переменной. А ошибочные значения будут штрафоваться пропорционально их отклонению от “идеального” значения.

Опять, рассмотрим два случая в каждой точке обучающей выборки. Допустим, истинное значение - 0 (правый график). Тогда при значениях $z <= -1$ мы вообще не штрафуем модель. То есть, говорим, что ошибка в этой точке равна нулю. Не приближается, а именно точно равна. Если же $z > -1$, то ошибка линейно возрастает пропорционально удалению от этой точки. Если же $y = 1$ (левый график) - то мы не штрафуем значения $z >= 1$. а остальные - так же пропорционально удалению.

Обратите внимание, что такая ошибка подразумевает, что некоторый диапазон значений $z$ штрафуется в любом случае. Но в каждом случае, есть некий порог, при преодолении которого ошибка обращается в ноль. И так же, как и в классической модели логистической регрессии, полная ошибка вычисляется как сумма ошибок в каждой точке. Такая ошибка позволяет максимизировать зазор между разделяющей гиперплоскостью и крайними точками выборки. Именно за счет такого усиления формы ошибки. А эти крайние точки и называются опорными векторами.

Однако, есть одна проблема практического свойства. Как вы могли заметить, такая функция ошибки не везде дифференцируема. Поэтому для реализации такой модели мы прибегаем к трюку. Можно заметить, что положение нашей границы принятия решений определяется исключительно положением этих крайних точек, то есть опорных векторов.

На данном графике показаны опорные вектора (точки), которые определяют “полосу” нейтральной зоны. И граница принятия решения должна располагаться ровно посередине этой полосы. Причем, в зависимости от взаимного положения точек и их принадлежности разным классам, опорных векторов может быть разное количество. Но их будет как минимум два - по одной точке от каждого класса.

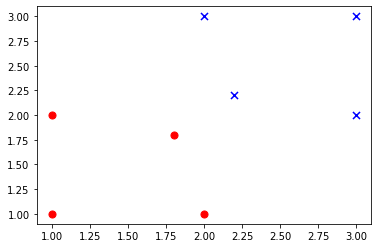

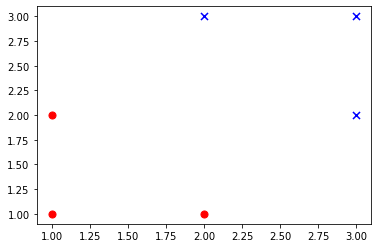

Поэтому вместо того, чтобы вычислять функцию ошибки, нам нужно найти в обучающей выборке те самые опорные вектора. В двумерной задаче это может быть сделано достаточно просто - мы можем найти такие точки выборки, которые имеют наименьшее расстояние от точек противоположного класса. Например, рассмотрим такую выборку:

Эта выборка соответствует такому расположению точек:

1

2

3

4

5

6

7

8

9

10

11

X = np.array([

[1, 2],

[2, 1],

[1, 1],

[2, 3],

[3, 2],

[3, 3],

[1.8, 1.8],

[2.2, 2.2]

])

Y = np.array([0, 0, 0, 1, 1, 1, 0, 1])

Мы можем найти матрицу расстояний от каждой точки до каждой другой:

1

X1 = np.array([[distance(p1, p2) for p1 in X] for p2 in X])

1

2

3

4

5

6

7

8

[[0. , 2. , 1. , 2. , 4. , 5. , 0.68, 1.48],

[2. , 0. , 1. , 4. , 2. , 5. , 0.68, 1.48],

[1. , 1. , 0. , 5. , 5. , 8. , 1.28, 2.88],

[2. , 4. , 5. , 0. , 2. , 1. , 1.48, 0.68],

[4. , 2. , 5. , 2. , 0. , 1. , 1.48, 0.68],

[5. , 5. , 8. , 1. , 1. , 0. , 2.88, 1.28],

[0.68, 0.68, 1.28, 1.48, 1.48, 2.88, 0. , 0.32],

[1.48, 1.48, 2.88, 0.68, 0.68, 1.28, 0.32, 0. ]]

Конечно, на главной диагонали будут нули. Но нам нужно выбрать из этой матрицы минимально значение между двумя точками, принадлежащими разным классам. Такое значение всегда будет. Поэтому хотя бы два опорных вектора будут всегда присутствовать в любой задаче. В нашем случае это расстояние между последней и предпоследней точками, а именно значение 0,32. Значит эти две точки и будут опорными векторами в данной обучающей выборке.

Рассмотрим другой пример:

В этой выборке мы удалили две центральные точки. Где же будут опорные вектора? Так же рассмотрим матрицу взаимных расстояний точек:

1

2

3

4

5

6

[[0, 2, 1, 2, 4, 5],

[2, 0, 1, 4, 2, 5],

[1, 1, 0, 5, 5, 8],

[2, 4, 5, 0, 2, 1],

[4, 2, 5, 2, 0, 1],

[5, 5, 8, 1, 1, 0]]

Учитывая, что нам нужны расстояния между точками разных классов, находим, что между точками 0-3 и 4-1 минимальное расстояние - 2. Можете проверить самостоятельно - меньшие расстояния в матрице только между точками одного класса. Это, вообще, типичный случай, ведь расстояние между точками - это некоторая мера их сходства. А схожие точки чаще принадлежат одному классу, чем разным.

Получается, что в этой выборке сразу четыре опорных вектора? Да, и такое бывает. Вообще, опорных векторов может быть любое количество, это зависит от взаимного расположения точек в пространстве.

Важно то, что эти опорные вектора однозначно определяют положение границы принятия решений. Если изменить положение хотя бы одного опорного вектора - то положение границы изменится. А если изменить положение точки, которая не является опорным вектором, то граница останется на том же месте. Это позволяет при классификации использовать положение всего нескольких точек выборки.

Следует заметить, что при изменении положения неопорной точки она сама может стать опорной, если приблизится к границе принятия решений. Поэтому, конечно, при изменении данных модель следует пересчитать заново.

Однако, при размерности точек, большей двух, нахождение опорных векторов уже не так тривиально. И эту задачу решают при помощи численной оптимизации. Ставится эта задача так. Граница принятия решения определяется как область точек, скалярное произведение которых с заданным вектором постоянна. Этот заданный вектор вычисляется как линейная комбинация векторов признаков с параметрами. Или, другими словами, взвешенное среднее векторов признаков, где веса выступают параметрами. Вектор параметров в таком случае выступает как нормальный вектор к разделяющей гиперплоскости.

Причем этот вектор (его обычно обозначают $w$ и он в наших обычных терминах будет состоять из таких компонент: $\vec{b} = {b_1, b_2, …, b_n}$) не обязательно единичной длины, как обычно в линейной алгебре. Ширина зазора между гиперплоскостью и точками однозначно определяется как величина, обратная к длине нормального вектора. Поэтому задача сводится к минимизации длины нормального вектора, при сохранении условия, что все точки классифицируются правильно.

Последнее требование можно смягчить, ведь на практике не все выборки являются линейно разделимыми. Поэтому классификатор может допускать некоторую степень неправильных классификаций. Таким образом оптимизироваться будет некоторая величина, состоящая и из длины нормального вектора и из суммарной ошибки классификации. Эта задача решается методом поиска седловой точки функции Лагранжа, рассмотрение которого выходит за рамки данного пособия.

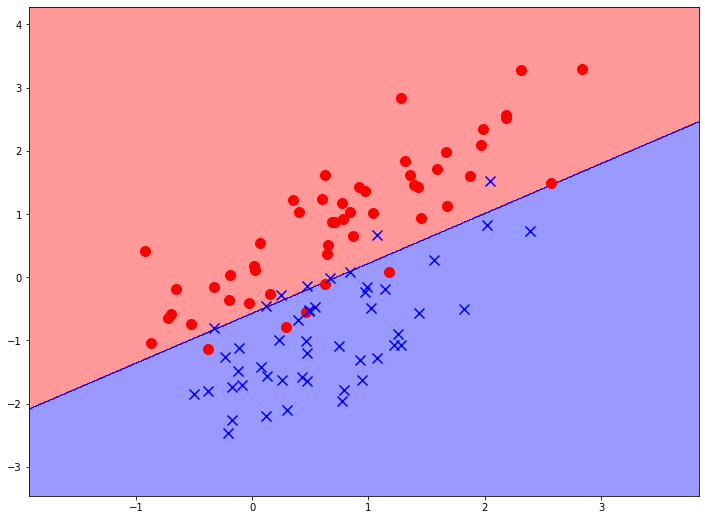

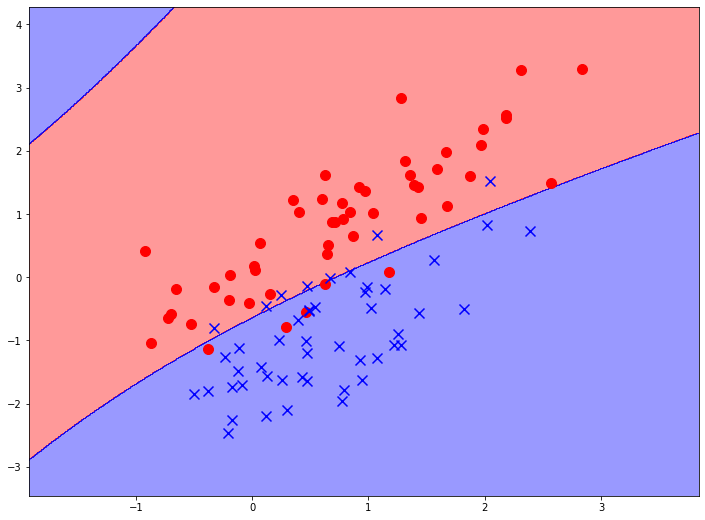

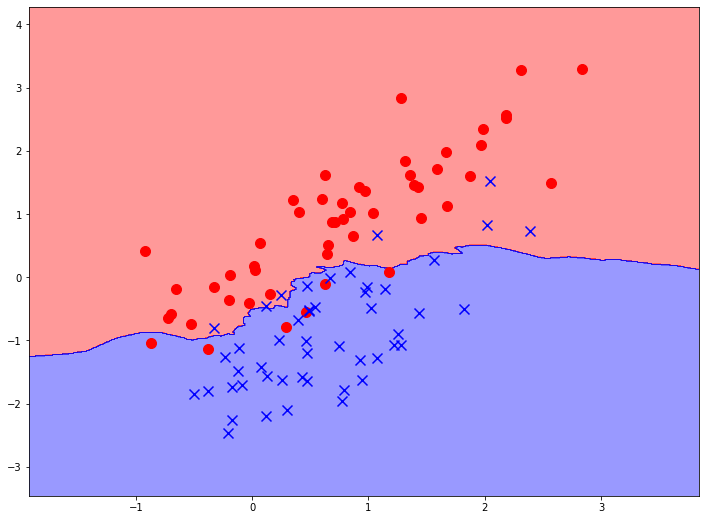

Важно то, что представленная таким образом задача приводит к нахождению разделяющей гиперплоскости максимального зазора. На графике вы можете видеть результат применения данного метода к уже использованным нами данным:

Можно видеть, что результат достаточно близок к результату применения линейной регрессии. Вообще, метод опорных векторов в такой формулировке в чем-то аналогичен линейным методам. Он дает линейную границу принятия решений. Но так же может использоваться и для нахождения линейной регрессии:

В таком виде метод опорных векторов просуществовал с начала 60-х до начала 90-х годов. В это время исследователи догадались, что такая постановка задачи позволяет совершить один трюк, который сильно расширяет применение и вариативность метода опорных векторов. Этот трюк может быть применен для решения линейно неразделимых задач, то есть для построения нелинейных границ принятия решений. Давайте для примера рассмотрим двумерную выборку, точки которой располагаются на плоскости примерно так:

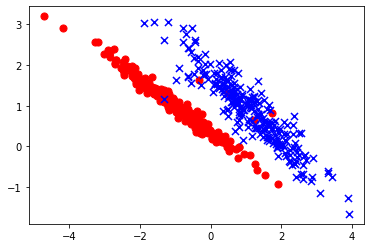

Очевидно, что данные могут быть разделены некоторой не очень сложной кривой. Но конкретный вид этой кривой достаточно сложно найти. В полиномиальной модели мы просто добавляем полиномиальные признаки “вслепую”, используя все комбинации. Это очень неэффективно. Метод опорных векторов тоже позволяет перейти в пространство более высоких размерностей, но без использования “полного перебора” всех комбинаций до заданной степени полинома, а используя так называемый “ядерные функции”.

Давайте зададимся вопросом. Можно ли более эффективно задать признаки для данной выборки точек? Глядя на график становится очевидно, что точки положительного класса (синие) расположены двумя пересекающимися примерно круглыми группами. А точки отрицательного класса (красные) расположены вне этих круглых кластеров. Это наводит на мысль, что в качестве признаков в модели мы можем использовать вообще не само расположение этих точек. Например, что если признаком сделать расстояние от данной точки до выбранных “центров кластеров”? Тогда данная проблема станет линейно разделимой. Хотя граница принятия решения будет сложной формы.

Математически доказано, что такая постановка проблемы эквивалента использованию в методе опорного вектора вместо скалярного произведения другой функции - радиально-базисной. Это и называется “ядерной функцией” или “функцией ядра” метода опорных векторов. То есть мы не изменяем саму задачу, но по-другому определяем саму разделяющую гиперплоскость. В данном случае - разделяющей гиперплоскостью будем считать множество точек $x$, которые удовлетворяют следующему равенству:

где $x_i$ - опорные вектора (в нашем примере - центры кластеров), $\alpha_i$ - их веса, а $k$ - ядерная функция (некоторая мера расстояния или сходства между точками).

Если правильно подобрать опорные вектора, то наша выборка станет абсолютно линейно разделимой. Как и раньше мы можем думать об этом преобразовании, как о добавлении новых признаков в модель (в нашем случае происходит даже замена признаков, потому что изначальные атрибуты не используются), либо как формирование нелинейной границы принятия решений в исходном пространстве.

На практике встает вопрос: а как выбирать эти самые опорные вектора? В простых случаях, как на графике выше, мы можем их проставить вручную, но это очень не универсальный способ. Конечно, нужен метод, который находит их автоматически. И вот здесь как раз используется тот же самый математический аппарат, что и в описанном выше линейном случае. Мы не находим и не задаем опорные вектора сами, мы используем все точки обучающей выборки и оптимизируем их веса таким образом, чтобы он был тем выше, чем “больше” точка является опорной.

Когда мы рассматривали простой линейный случай, точки выборки у нас могли быть либо опорными, либо нет. Но на самом деле все немного сложнее. Ведь любая гиперплоскость однозначно определяется всего одним вектором - нормальным. А этот нормальный вектор “составляется” как взвешенная сумма векторов, соответствующих всем точкам обучающей выборки. Другими словами, в качестве опорных векторов для начала берут сами точки обучающей выборки. А затем, в процессе обучения, быстро становится понятно, что не все точки “одинаково полезны”. У таких не полезных точек вес будет равен или очень близок к нулю. Если же точка близка к центру кластера, то ее вес будет ненулевым.

На самом деле, конечно, гиперплоскость задается не только нормальным вектором, но еще и некоторым числом. Это число характеризует расстояние плоскости от центра координат. Это число - это свободный коэффициент $b_0$. Если помните, вектор $w$ в методе опорных векторов как раз задавался без него. Этот параметр $b_0$ в совокупности с другими параметрами однозначно задает разделяющую гиперплоскость. Здесь присутствует некоторая информационная избыточность, ведь, например, в двух измерениях, разделяющая прямая задается уравнением $b_0 + b_1 x_1 + b_2 x_2 = 0$. Это уравнение имеет 3 параметра, но всего 2 степени свободы. Ведь его можно свободно умножить на любое ненулевое число.

Для полного определения нашей нелинейной модели на опорных векторах, нужно лишь охарактеризовать саму “ядерную функцию”. Мы уже сказали, что в качестве функции ядра может применяться скалярное произведение векторов. Если мы зафиксируем некоторую точку (вектор) в пространстве, то постоянное скалярное произведение даст нам множество плоскостей, равноудаленных от данной точки. А для решения нашей второй, нелинейной задачи, нам нужна функция, которая даст окружность вокруг данной точки. Такая ядерная функция называется радиально-базисная и формулируется следующим образом:

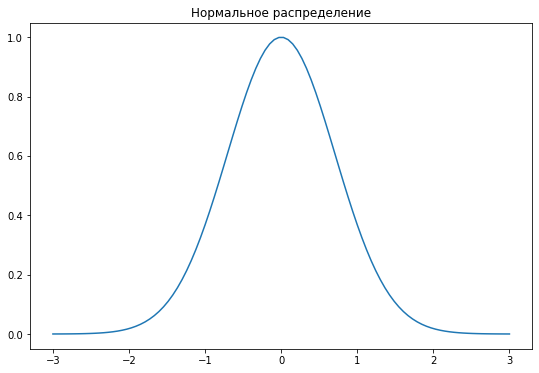

Вид этой функции очень похож на нормальное распределение. Поэтому данная функция еще называется гауссовой. Относительно конкретной точки эта функция показывает некоторую меру сходства. которая убывает при росте евклидова расстояния от нее. Действительно, если мы посчитаем радиально-базисную функцию от двух совпадающих точек, мы получим 1. Если же точки будут бесконечно далеки друг от друга, то значение функции будет стремиться к нулю. В общем случае, эта функция ведет себя как распределение Гаусса, откуда и название.

Применение этой функции в методе опорных векторов означает, что мы строим разделяющую гиперплоскость, выглядящую как множество равноудаленных точек от некоторого средневзвешенного вектора в пространстве высокой размерности. Если мы спроецируем эту границу принятия решений в наше изначальное пространство, то оно будет выглядеть как некоторая кривая (в большинстве случаев замкнутая), похожая на эллипс, то есть кривую второго порядка, но более сложной формы. Сложность границы принятия решений в методе опорных векторов зависит не от нелинейности ядерной функции, а от того, сколько точек выборки метод примет за опорные.

Метод опорных векторов с гауссовым ядром очень редко применяется для решения задач регрессии, так как обладает очень характерным поведением, которое вы можете видет на графике. Это поведение достаточно редко встречается в реальной жизни в данных, предполагающих регрессионные задачи.

Так как метод опорных векторов не привязан к конкретной задаче - регрессии или классификации - в общем виде он обозначается SVM - support vectors machine. Если же мы говорим о его адаптации к задаче регрессии, то можно встретить аббревиатуру SVR - support vectors regressor, то есть регрессор на основе метода опорных векторов. И, соответственно, существует SVC - support vectors classifier, классификатор на опорных векторах.

Следует заметить, что описанный выше алгоритм линейной классификации при помощи метода опорных векторов, когда в качестве ядреной функции применяется скалярное произведение, называется метод опорных векторов с линейным ядром. Он же, по ряду причин, называется метод опорных векторов без ядра. Имейте это в виду, данная терминология может немного ввести в заблуждение.

В качестве функции расстояния можно брать разные метрики (они должны удовлетворять определенным условиям). С большим отрывом чаще всего применяются на практике линейное и гауссово ядро. А так как линейное ядро почти всегда аналогично применению обычной линейной регрессии, по умолчанию почти всегда применяется именно гауссово ядро. В библиотечных реализациях метода опорных векторов обычно есть возможность выбрать их нескольких уже готовых ядерных функций.

Наиболее распространенные ядерные функции:

- Линейное (SVM без ядра): $ (x \cdot x’) $

- Радиальная базисная функция: $ e^{-\gamma \mid x - x’|^2} $

- Полиномиальное: $ (x \cdot x’)^d $

- Полиномиальное смещенное: $ (x \cdot x’ + 1)^d $

- Сигмоида: $ tanh(k x \cdot x’ + c) $

Метод опорных векторов с разным типом ядер дает разный тип границы принятия решений. Например, ниже вы видите результат работы классификатора на опорных векторах с полиномиальным ядром. Полиномиальное ядро подразумевает, что предварительно надо задать еще и степень полинома. По умолчанию, и на графиках ниже используется третья степень.

Такой же метод опорных векторов с полиномиальным ядром третьей степени, но уже для решения задачи регрессии. Можно заметить, что кривая несомненно сложнее, чем кривая третьего порядка. Ведь сложность границы принятия решения зависит от количества опорных векторов.

Метод опорных векторов имеет ряд преимуществ и недостатков по сравнению с линейными и полиномиальными моделями. Он, несомненно, более эффективен в построении нелинейных границ принятия решений, чем полиномиальные модели. Он более универсален, чем линейные. Но надо помнить, что в процессе нахождения опорных векторов в какой-то момент приходится оценивать расстояние между точками выборки. Поэтому данный метод может выполняться довольно медленно, если точек большое количество. Но с другой стороны, если в задаче количество точек сильно меньше, чем количество атрибутов, метод опорных векторов наоборот, может дать преимущество в скорости.

Но метод опорных векторов менее интерпретируем и понятен, чем линейные модели. Результат работы классификатора нельзя интерпретировать как вероятность принадлежности объект данному классу, как в линейных и полиномиальных моделях. А это затрудняет его использование в мультиклассовых задачах (то ест в таких, где объект может одновременно принадлежать нескольким классам) и в задачах нечеткой классификации.

Выводы:

- Метод опорных векторов находит оптимальную разделяющую гиперплоскость, а значит приводит к более уверенной классификации.

- SVM может реализовывать нелинейные модели за счет применения функций ядер.

- Метод опорных векторов может использоваться как для регрессии (SVR), так и для классификации (SVC).

- SVM эффективны, когда количество атрибутов больше количества объектов.

- SVM очень чувствителен к шуму, выбросам в данных.

- SVM не дают прямых оценок вероятности принадлежности.

Перцептрон

Перцептрон - это самый простой вид искусственных нейронных сетей. Вообще, подробное рассмотрение нейронных сетей выходит за рамки этого пособия, это отдельная и очень глубокая тема, требующая подробного изучения. Но именно перцептрон довольно часто используется наряду с другими классическими методами обучения с учителем. Поэтому здесь мы рассмотрим основные принципы работы перцептрона именно для решения относительно простых задач регрессии и классификации, без подробного рассмотрения техник глубокого обучения. Для того, чтобы познакомиться с работой нейронной сети, рассмотрим сначала принцип действия одного искусственного нейрона.

На минутку возвратимся к обычной логистической регрессии. Ее можно схематически изобразить, как прохождение сигнала (численной информации) по такой схеме:

Здесь есть несколько входов $x_i$ - на которые подаются значения соответствующих признаков. Затем каждое из этих значений умножается на соответствующий ему вес - $w_i$ (именно они подбираются в процессе обучения), затем они суммируются, а после этого эта взвешенная сумма подается на вход некоторой нелинейной функции (в случае логистической функции - сигмоидальной). Обратите внимание, что на схеме присутствует один постоянный вход, на который подается всегда значение 1 - это искусственный константный признак, который нужен для учета свободного слагаемого в взвешенной сумме.

Таким образом модель логистической регрессии представляется в виде некоторого объекта, у которого есть несколько входов, один выход и какие-то внутренние параметры:

Этот объект в определенном смысле похож на то, как функционирует биологическая клетка нервной системы - нейрон. Он тоже имеет несколько входов, на которые могут быть поданы электрические сигналы. Если сумма этих сигналов превышает некоторый порог, то активируется выходной сигнал нейрона. Поэтому такое представление модели называется моделью нейрона, а программа, которая его реализует - искусственным нейроном. Мы можем пользоваться этим нейроном, как моделью классификации. Для этого на его входы надо подать значения, соответствующие значениям признака классифицируемого объекта. Тогда на выходе мы получим некоторое значение, которое можно интерпретировать, как значение бинарной классификации.

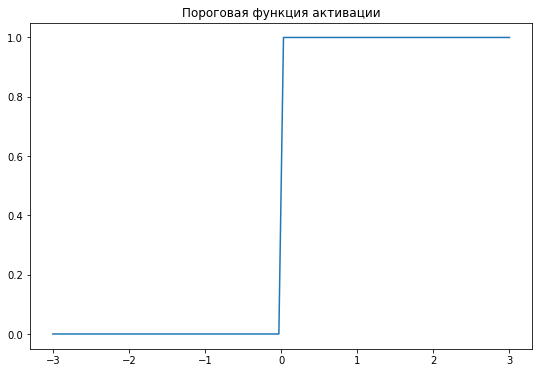

В искусственном нейроне можно использовать разные функции активации. Исторически, чаще всего использовалась так называемая ступенчатая функция. Она принимает значение 0, если на вход ей подается значение меньше либо равно нулю, или 1, если подается положительное значение. Другими словами эта функция активирует нейрон, если значение взвешенной суммы входных сигналов больше какого-то значения. Причем, это пороговое значение может регулироваться свободным параметром $w_i$. Так, пороговая функция эмулирует поведение биологического нейрона.

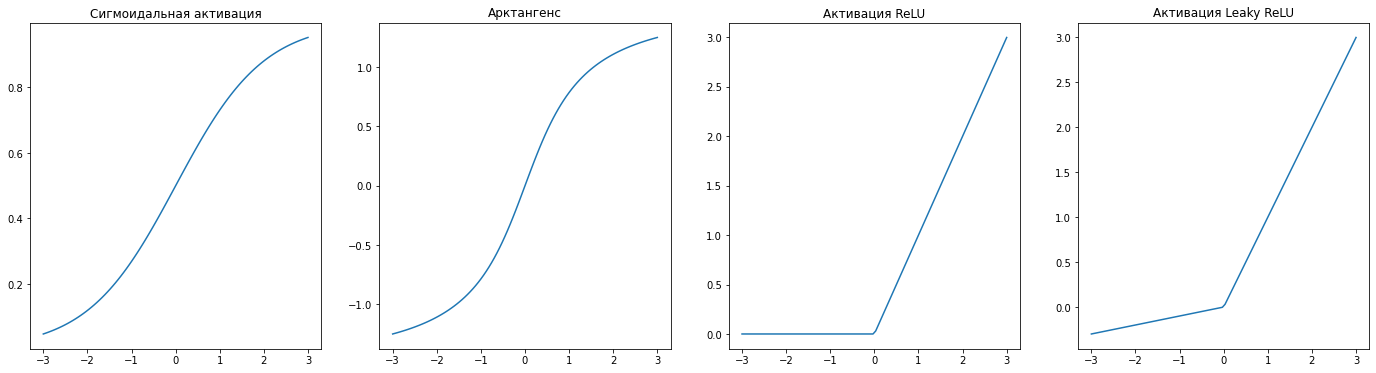

Но для прикладного применения такая функция не обязательно оптимальна, и поэтому можно использовать другие. Например, как мы уже говорили, если взять логистическую функцию активации, то такой нейрон будет полностью аналогичен модели логистической регрессии. Но на практике часто используют так называемую функцию ReLU (rectified linear unit):

Но чем искусственный нейрон принципиально отличается от других моделей машинного обучения? Ключевых отличий два: возможность объединения в сети и алгоритм обучения. Сам по себе один нейрон представляет собой довольно простую модель, но именно такое представление позволяет очень просто объединять несколько нейронов - то есть соединять выход одного нейрона со входом другого, другими словами, подавать результат работы одного нейрона как значение признака другому. Такое становится возможным благодаря тому, что нейроны используют особую разновидность метода градиентного спуска для обучения - так называемый метод обратного распространения ошибки. Давайте на примере рассмотрим механизм обучения одного нейрона (однослойного перцептрона).

Создадим каркас нашего класса. В нем определим поля для хранения весов и смещения (в нейронных сетях они традиционно хранятся отдельно, хотя вы можете использовать и суррогатный признак), а также функцию активации (в данном случае используем пороговую функцию активации, она проще всего в вычислениях):

1

2

3

4

5

6

class Perceptron:

def __init__(self):

self.weights = None

self.bias = None

def activation_func(self, x):

return np.where(x>=0, 1, 0)

обратите внимание, что мы не инициализируем вектор весов, так как его размерность будет напрямую зависеть от количества признаков в данных.

Теперь определим функцию прямого распространения - то есть выполнение предсказания. Для этого используем переданную матрицу признаков (или вектор, если объект один), которую будем умножать на вектор весов. Конечно, предполагается, что вектор весов для этого должен быть инициализирован. Это мы будем делать в функции обучения. Так что перцептрон нужно сначала обучить, а уже потом применять. Прямое распространение сводится к вычислению линейной комбинации $z$, которую нужно пропустить через функцию активации:

1

2

3

def predict(self, X):

z = np.dot(X, self.weights) + self.bias

return self.activation_func(z)

Теперь можем приступить к реализации функции обучения. Здесь мы сначала инициализируем вектор весов случайными значениями. Обратите внимание, что нейронные сети нужно всегда инициализировать именно случайно. Для единственного нейрона это не критично, но многослойные нейронные сети должны иметь разные веса у нейронов на одном слое.

1

2

def fit(self, X, y):

self.weights = np.random.rand(X.shape[1])

Алгоритм обучения сводится к немного модифицированному градиентному спуску. В данном примере мы будем вычислять ошибку для каждого объекта обучающей выборки. Для градиентного спуска нам нужно сформировать функцию ошибки. Возьмем среднеквадратическое отклонение. В данном случае, так как используется всего один объект, это будет просто квадрат отклонения эмпирического значения от полученного:

В этой формуле $y$ - эмпирическое или истинное значение целевой функции. А $a^{(L)}$ - это значение функции активации нейрона на последнем слое. Другими словами это по сути и есть значение модели. В нейронных сетях так принято обозначать результат работы нейрона, и эти обозначения станут полезными, когда мы будем говорить о многослойных сетях. $L$ в данном случае - просто количество слоев.

При описании математики работы нейронных сетей часто приходится видеть обозначение номера слоя в виде верхнего индекса в скобках. Следует помнить, что это не возведение в степень, а именно индекс, то есть просто номер слоя, которому принадлежит данный параметр. Дело в том, что нижние индексы обычно заняты обозначением номера нейрона в слое. Также обратите внимание, что к слоям мы обращаемся с конца - сначала работаем с последним, затем с предпоследним и так далее. Это же алгоритм обратного распространения ошибки. Поэтому мы обозначаем слои не 1, 2, …, а через $L$ - количество слоев - $L$ - последний, $L-1$ - предпоследний и так далее.

Результат работы нейрона зависит от двух факторов - от значения весов $w^{(L)}_i$ (опять в обозначениях упоминается номер слоя, в данном случае - последний.) и от свободного парамера $b^{(L)}$. Для того, чтобы понять, как нам нужно поменять эти параметры, чтобы уменьшить ошибку, нужно вычислить градиент, или просто частную производную. Начнем с весов. Для упрощения расчетов сразу применим правило производной сложной функции:

Другими словами, зависимость значения ошибки от веса складывается из зависимости значения ошибки от значения нейрона, зависимость значения нейрона от линейной комбинации и значения линейной комбинации от веса. Давайте найдем эти частные производные по порядку:

Зависимость ошибки от значения нейрона следует из самой формулировки функции ошибки. Заметим только, что постоянный множитель можно в дальнейшем игнорировать, так как по методу градиентного спуска мы все равно будем домножать получившееся выражение на скорость обучения.

При расчете частной производной значения функции активации нейрона от линейной комбинации мы сталкиваемся в проблемой. Дело в том, что мы используем ступенчатую функцию активации, а ее производная равна нулю везде, где определена. По этой самой причине эта функция активации и не используется в многослойных нейронных сетях. Сейчас, без потери обучающей способности метода мы примем эту производную за единицу. Но имейте в виду, что в общем случае так делать нельзя, это математический трюк только для однослойного перцептрона и только для этой функции активации.

Частная производная линейной комбинации по весу равна входному значению. В данном случае - это сами атрибуты датасета, которые подаются на вход нашему нейрону:

Таким образом мы получаем правило для изменения значения весов нейрона:

Теперь проделаем те же манипуляции для свободного коэффициента. Так же используем правило производной сложной функции и разложим ее на аналогичные составляющие:

Здесь все полностью аналогично за исключением последнего множителя:

Здесь все еще проще - так как коэффициент свободный, производная по нему равна единице:

Таким образом аналогично обновляем значение свободного коэффициента:

Вот как это выглядит в виде программного кода:

1

2

3

4

5

6

7

8

def fit(self, X, y):

self.weights = np.random.rand(X.shape[1])

# for _ in range(1000):

for idx, x_i in enumerate(X):

y_pred = self.predict(x_i)

update = 0.01 * (y[idx] - y_pred)

self.weights += update * x_i

self.bias += update

Теперь можно использовать данную модель и обучить ее на каких-нибудь данных:

1

2

3

4

p = Perceptron()

p.fit(X, Y)

y_pred = p.predict(X)

accuracy_score(Y, y_pred)

Если запустить этот код, можно убедиться, что модель работает, но результат предсказания не очень хороший. Дело в том, что на мы по сути делаем только один шаг градиентного спуска. Для полноценного обучения модели нужно повторить процесс подстраивания параметров много раз, аналогично с тем, как мы поступали для линейной регрессии. Вот как выглядит итоговый код:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

class Perceptron:

def __init__(self):

self.weights = None

self.bias = 0

def fit(self, X, y):

self.weights = np.random.rand(X.shape[1])

for _ in range(1000):

for idx, x_i in enumerate(X):

y_pred = self.predict(x_i)

update = 0.01 * (y[idx] - y_pred)

self.weights += update * x_i

self.bias += update

def predict(self, X):

z = np.dot(X, self.weights) + self.bias

return self.activation_func(z)

def activation_func(self, x):

return np.where(x>=0, 1, 0)

Теперь поговорим про вторую главную особенность искусственных нейронов, из-за которой они стали очень популярны - способность объединяться в нейронные сети. А зачем вообще объединять нейроны в сеть? Как мы уже говорили ранее, для более эффективного моделирования к атрибутам можно добавлять искусственные, суррогатные признаки. Как в модели полиномиальной регрессии, когда добавление, например, признака $x_1^2$ может сделать классификацию значительно проще. Но на практике очень сложно заранее предугадать, какие именно суррогатные признаки будут полезны.Может быть, в модель стоит добавить признак $x_1 + x_2$? Или $3x_1 - 4x_3^2$? Это называется задача извлечения признаков. Ее можно решать в ручном режиме, когда аналитик сам создает суррогатные признаки исходя из интерпретации предметной области, постановки задачи и смысла имеющихся атрибутов. Но вообще, хотелось бы, чтобы эта задача решалась автоматически. Давайте представим уже известный нам перцептрон, но мы хотим, чтобы на его вход подавались не существующие атрибуты, а подобранные оптимальные признаки:

Этого можно добиться, подставив вместо каждого входа еще по одному нейрону, каждый из которых получает на вход атрибуты и выдает результат. Такая модель называется многослойным перцептроном - это простейшая нейронная сеть, в которой есть три слоя: входной слой, на котором подаются значения имеющихся в датасете атрибутов; выходной слой, нейрон на котором выдает результат классификации; и скрытый слой, на котором какое-то количество нейронов преобразуют атрибуты в признаки:

Почему такая модель будет подбирать оптимальные признаки? Дело в алгоритме обучения нейронной сети. Давайте подумаем, сколько параметров будет у такой модели? Она состоит из четырех нейронов, у каждого из которых по три входа. Три входа - значит четыре внутренних параметра (помните, что один параметр является свободным, в нейронных сетях он обычно называется bias или нейрон смещения). Итого получается 16 параметров. И они обучаются все вместе таким образом, чтобы при работе этой сети на обучающей выборке ее ответы как можно больше совпадали с имеющимися. То есть алгоритм обучения нейронных сетей подбирает оптимальное значение всех параметров сети для наилучших предсказаний. Веса последнего нейрона подбираются такие, чтобы из признаков получать нужные значения, а нейронов на скрытом слое - так, чтобы из атрибутов получать наилучшие линейные комбинации, которые после нелинейного преобразования (функции активации) давали наилучшие для предсказания признаки.

Соединять нейроны можно по-разному, в разном порядке, с обратными связями, циклами, используя нейроны разных типов, разные функции активации. Схема соединения нейронов называется архитектурой нейронной сети. Нейронные сети - это попытка алгоритмической имитации деятельности головного мозга человека. Существует большое количество шаблонов архитектуры нейросетей. Но самая простая - это перцептрон, который мы и рассматривали выше. Это сеть прямого распространения, то есть в ней сигнал идет строго в одном направлении - от входа к выходу, без соединений в обратную сторону. И нейроны в нем организуются в слои. Причем эти слои являются полносвязными, то есть все нейроны одного слоя соединены со всеми нейронами следующего слоя.

Как мы говорили ранее, нейронные сети используют специальный вариант алгоритма градиентного спуска для подбора своих параметров. Зачем же изобретать новый алгоритм обучения? Делов именно в том, что нейронные сети могут быть многослойными. И алгоритм обучения должен легко подстраиваться под любое количество слоев и нейронов в нем. Поэтому не очень удобно рассматривать множество всех параметров нейронной сети как один плоский вектор. Давайте рассмотрим чуть подробнее, как работает алгоритм обучения нейронных сетей - алгоритм обратного распространения ошибки.

В многослойной сети значение каждого нейрона зависит от трех факторов - его входных весов, веса нейрона смещения (другими словами, свободного коэффициента) и значения нейронов на предыдущем слое. Функция ошибки формулируется точно так же, как и в предыдущем примере с одним слоем. Зависимость функции ошибки от этих трех факторов выражаются частными производными. Производную функции ошибки о свободного коэффициента $b^{(L)}$ мы уже рассматривали, она не меняется. Производная ошибки от веса вычисляется аналогично, но в отличии от однослойного перцептрона, вес умножается не на значение атрибута, а на значение нейрона на предыдущем слое, поэтому:

А вот зависимость значения текущего нейрона от значения нейронов на предыдущем слое мы еще не анализировали. Принцип здесь тот же самый, раскладываем эту производную по правилу сложной функции:

Два первых множителя здесь полностью аналогичны другим факторам:

А вот зависимость линейной комбинации от значения предыдущего нейрона выражается просто коэффициентом при этом значении - то есть весом данного входа в текущем нейроне:

Таким образом мы получаем значение, на которое надо изменить значение нейрона на предыдущем слое, чтобы уменьшить функцию ошибки:

Но эта ситуация аналогична тому что мы рассматривали изначально - есть текущее значение нейрона, есть его отклонение от нужного значения. Только теперь мы должны изменить значение другого нейрона, расположенного на предыдущем слое. А это значение, в свою очередь, зависит от его весов, свободного параметра и значения нейронов на еще более предыдущем слое. То есть анализируя, насколько нам нужно изменить параметры нейрона на текущем слое, мы получили информацию, насколько нам нужно изменить значение нейронов на предыдущем слое. То есть ошибка (отклонение) как бы распространилась от последнего слоя нейронной сети на предыдущий слой. И нам нужно повторить тот же алгоритм подстройки для нейронов, расположенных на предпоследнем слое. А затем - на предыдущем и так далее, пока мы не “упремся” в нейроны первого слоя, на котором действует та математика, которую мы рассматривали в предыдущем примере с однослойным перцептроном.

Есть одно замечание. Для упрощения, мы рассматривали только один нейрон на каждом слое. Но в реальности, слой нейронной сети может состоять из произвольного количества нейронов. Для обозначения номера нейрона на конкретном слое будем использовать нижние индексы. Так $a^{(L)}_i$ - это значение i-го нейрона на слое L нейронной сети. А $w^{(L)}_{jk}$ - это вес k-го входа j-го нейрона на том же слое. Количество нейронов на слое $L$ обозначим как $n_L$.

Следует иметь в виду, что на необходимое изменение значения нейрона на предыдущем слое будут оказывать влияние сразу несколько нейронов последующего слоя (а именно все нейроны последующего слоя). Поэтому для получения необходимого отклонения для данного нейрона нужно брать сумму всех производных, вычисленных для каждого нейрона последующего слоя:

В индексах здесь легко запутаться. Для более полного понимания алгоритма обучения нужно очень тщательно проследить все обозначения, лучше всего при помощи графического представления многослойного перцептрона. Для интуитивного понимания смысла его работы достаточно проследить все факторы, влияющие на значение нейрона на выходном слое, а также помнить, что если на величину влияет сразу несколько факторов, то алгоритм просто суммирует их влияние. Важно, что алгоритм обратного распространения ошибки для каждого нейрона абсолютно аналогичен. Именно поэтому не приходится как-то его модифицировать для разного количества нейронов и слоев. Поэтому он так удобен для обучения сложных и глубокий нейронных сетей.

Это лишь обзор алгоритма обучения и работы нейронных сетей. Это действительно очень сложная тема, поэтому не расстраивайтесь, если при первом знакомстве вы не смогли полностью понять математические методы и смысл действия этих алгоритмов и моделей. Детально рассмотрение видов, моделей нейронных сетей и алгоритмов их обучения - это отдельная и очень сложная область глубокого обучения, которая выходит далеко за рамки данного пособия. В этой главе мы лишь знакомимся с таким видом моделей машинного обучения, как нейронные сети на примере многослойного перцептрона. И на этом этапе достаточно интуитивного понимания принципов их работы.

Чем больше нейронов и слоев в нейронной сети, тем сложнее получаются модели. Количество нейронов в слое определяет, сколько признаков будет выделять данный слой из значений предыдущего для последующих. Количество же слоев выводит сложность модели на совершенно другой уровень. Это немного напоминает повышению степени полинома, хотя и не полностью аналогично. Важно понимать, что нейронные сети, особенно очень большие и глубокие - это очень сложные модели, которые могут быть склонны к переобучению. С другой стороны, именно глубокие нейронные сети способны решать очень сложные задачи анализа данных, особенно если данных в обучающей выборке очень много.

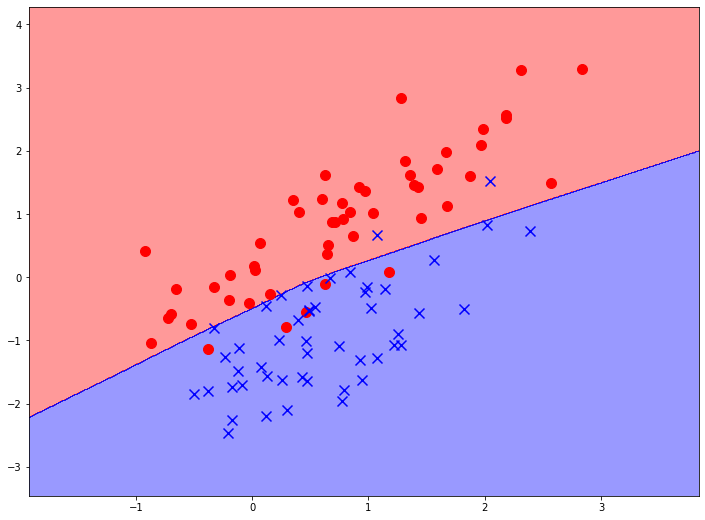

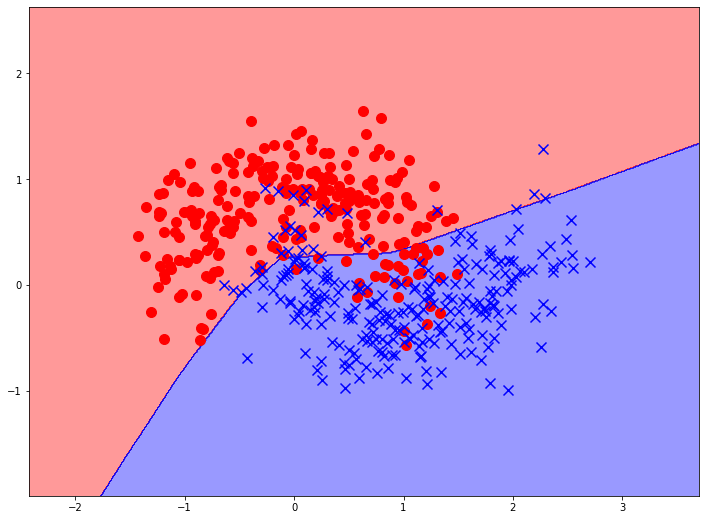

Но и небольшие и простые нейронные сети способны эффективно решать задачи простой классификации. Например, многослойный перцептрон с параметрами по умолчанию (1 скрытый слой с 100 нейронами) дает следующую границу принятия решений на модельных данных:

Та же конфигруация нейронной сети, но обученная на более сложном наборе данных так же неплохо справляется с их классификацией:

Если увеличить количество скрытых слоев, можно явно видеть усложнение формы границы принятия решения, что свидетельствует о повышении вариативности и сложности модели. При этом, в библиотечные реализации перцептрона встроены определенные механизмы предупреждения переобучения, что является главной бедой нейронных сетей на простых, малоразмерных задачах.

Одним из преимуществ нейронных сетей является их универсальность. Даже простые перцептроны могут разделять в задачах классификации данные, расположенные любым произвольным образом:

А что насчет задач регрессии? Нейронные сети очень легку приспособить для предсказания непрерывного значения. Для этого достаточно убрать функцию активации выходного нейрона. Можно сказать, что у последнего нейрона в качестве активации выступает тожественная функция ($y = x$). Тогда нейрон будет выдавать значение линейной комбинации, которая определена на всей числовой прямой. Алгоритм обучения, заметим, в таком случае вообще никак не изменяется! Обратим внимание, что, несмотря на линейность функции в последнем нейроне, вся модель, если она имеет хоть один скрытый слой является нелинейной из-за применения нелинейных функций активации на предыдущих слоях:

До сих пор мы говорили о моделях, на выходном слое которых только один нейрон. Они могут решать задачи бинарной классификации. Но что, если классификация множественная? В случае с нейронными сетями все очень просто. Мы создаем сеть, у которой на выходном слое несколько нейронов, по числу классов. Обучение такой модели предполагает, что при подачи на вход атрибутов объекта обучающей выборки, нейрон, соответствующий классу данного объекта должен показать 1, а остальные нейроны - 0. В остальном, алгоритм обучения такой сети остается без изменений. Тор есть мы просто кодируем в обучающей выборке значения целевой переменной единичными векторами, а нейронная сеть все сделает сама.

Точно так же просто можно использовать нейронные сети и для многоклассовой классификации. Для этого достаточно лишь отразить в обучающей выборке, что единица может присутствовать в нескольких выходных нейронах. Ну и, естественно, можно задать данные для нечеткой классификации. В этом смысле в полной мере раскрывается универсальность нейронных сетей.

Количество слоев и количество нейронов на каждом слое, а также порядок их соединения называется архитектурой нейронной сети. Вопрос выбора архитектуры нейронной сети зачастую решается произвольно, “на глаз”, исходя из соображений диагностики переобучения, про которую мы будем говорить в следующей части учебника. Определенные типы архитектур нейронных сетей традиционно применяются для анализа разных видов информации. Например, сверточные нейронные сети хорошо показывают себя в обработке изображений, рекуррентные сети - в анализе временных рядов, звуков речи, генеративные сети - в создании изображений и текстов, трансформеры - в анализе естественных текстов. Говоря о перцептронах, есть несколько эмпирических правил, которые могут помочь в выборе архитектуры сети. Количество нейронов на входном и выходном слое фиксировано и определяется данными в обучающей выборке. Количество скрытых слоев зависит от сложности задачи. И обычно нет смысла увеличивать количество нейронов в слоях. То есть если на каком-то слое, допустим, 16 нейронов, то на следующем можно сделать 16, 8, 4 и так далее, но нет смысла делать 50. Существуют автоматизированные способы подбора архитектур нейронных сетей, но они требуют невероятно больших вычислительных мощностей.

Основное преимущество нейронных сетей перед остальными моделями машинного обучения состоит в том, что они очень легко масштабируются. Возьмем простой двухслойный перцептрон, который мы рассматривали чуть выше. Если представить его в виде одной формулы, это будет очень сложная формула - ведь это логистическая функция, считающаяся от линейной комбинации трех других логистических функций от линейной комбинации трех входных переменных. Возьметесь дифференцировать эту функцию для метода градиентного спуска? А в виде нейронной сети эта модель представляется довольно простой, последовательной, даже в чем-то понятной. В этом очень помогает универсальный алгоритм обратного распространения ошибки, который позволяет произвольно задавать количество нейронов и слоев, без экспоненциального усложнения математического аппарата, необходимого для обучения такой модели.

Именно поэтому, нейронные сети позволяют строить очень сложные и вариативные модели для решения таких задач, на которых более традиционные модели недообучаются. Самые современные нейронные сети для, например, анализа и генерации текстов на естественных языках могут иметь десятки триллионов обучаемых параметров. Модели такого уровня сложность просто невозможно построить при помощи других алгоритмов, которые относятся к классическому машинному обучению.

Конечно, обучение таких гигантских моделей требует огромных вычислительных мощностей. Такие модели обучаются месяцами на самых современных суперкомпьютерах и кластерах. Вообще, глубокие нейронные сети, даже более скромные по размерам - это довольно вычислительно емкие модели. Но при этом, рост вычислительной сложности гораздо меньше, чем для других видов моделей. Ведь алгоритм применения (прямого распространения) и обучения (обратного распространения) нейронных сетей очень хороше векторизуются, то есть представляются в матричной форме. А компьютеры могут очень эффективно выполнять матричные операции, потому что они легко распраллеливаются. Именно поэтому обучение и применение нейронных сетей сильно выигрывает от применения вычислений на графических картах.

Но есть у нейронных сетей и недостатки. Кроме уже упомянутой вычислительной емкости, одним их главных является их неинтерпретируемость. Нейронные сети работают по принципу черного ящика - сигналы на входе, сигналы на выходе. Что происходит внутри, что значит каждый конкретный параметр - никто не знает. Это может показаться несущественным, но в некоторых областях применения, важно не только эффективное предсказание, но и объяснение выданного значения. Это очень сильно ограничивает применение нейронных сетей в таких областях как здравоохранение, государственной управление, социальная сфера и других подобных. Причем, чем больше и сложнее нейронная сеть, тем большей загадкой является ее внутренняя структура и принцип работы.

Выводы:

- Нейронные сети являются самым популярным методом обучения с учителем.

- Нейронные сети позволяют строить самые сложные и масштабируемые модели.

- Обучение и применение нейронных сетей очень хорошо распараллеливается. За счет этого можно ускорять их работу с помощью графических ядер и других средств.

- Перцептрон - самая простая архитектура нейронной сети, состоящая из нескольких полносвязных слоев.

- Нейронные сети работают по принципу черного ящика, их очень сложно интерпретировать.

- При применении нейронных сетей встает вопрос выбора архитектуры, количества нейронов.

- Главный параметр нейронной сети - количество скрытых слоев. Если их больше одного сеть называется глубокой.

- Нейронные сети очень естественно решают задачу множественной и мультиклассовой классификации.

Деревья решений

Деревья решений - это один из самых простых, но при этом популярных методов обучения с учителем. Они применяются как для построения моделей классификации или регрессии, так и для анализа данных, чтобы получить полезную информацию о некоторых зависимостях в них. Основное преимущество деревьев решений - понятность алгоритма и простота интерпретации результатов.

Дерево решений - это иерархическая структура, состоящая из правил вида “Если …, то…”. Примерно так же будет рассуждать человек, которому поставлена задача определить по имеющимся характеристикам объекта значение целевой переменной. В узлах дерева содержатся некоторые условия, или критерии, по отношению к которым объект может быть отнесен к одному из вариантов. Как правило, данные критерии бинарные и выражаются в оценке значения одного из признаков. Чаще всего при использовании непрерывных шкал признаков используется сравнение с пороговым значением.

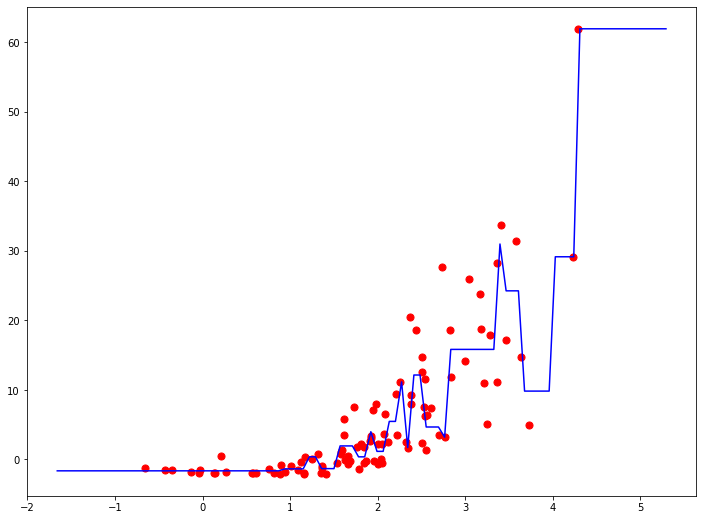

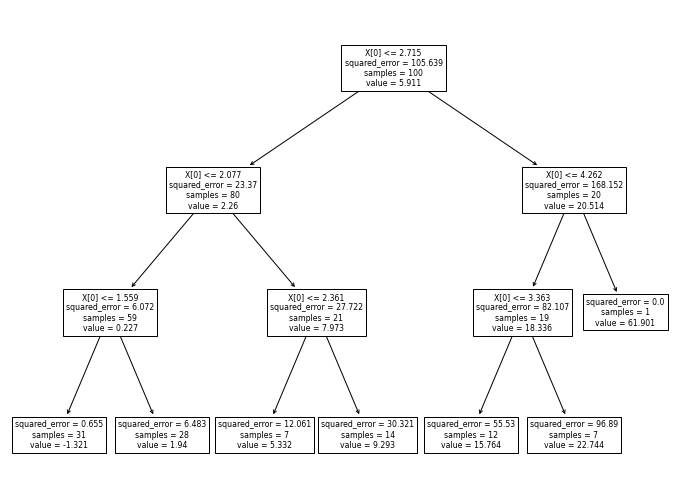

По результатам проверки в узле мы может пойти по одному из ребер и попасть либо в следующий узел с другой проверкой, либо в листьевой элемент, в котором содержатся значение целевой переменной. Если это задача классификации, то это конкретная метка класса. Если это задача регрессии - то это чаще всего конкретное значение целевой переменной. Однако, может использоваться линейная функция от признаков (В каждом листе - разная). Таким образом решается задача моделирования целевой переменной.

В машинном обучении деревья стоит задача нахождения оптимального дерева решений - такого дерева, который наилучшим образом предсказывает значение целевой переменной. Обучение - это подбор параметров. Параметрами дерева являются конкретные значения порогов в каждом узле. Также скрытым параметром является порядок “опроса” признаков.

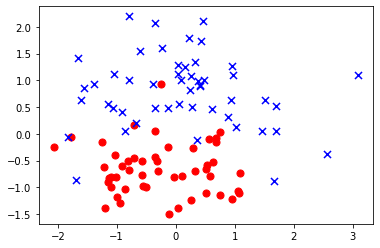

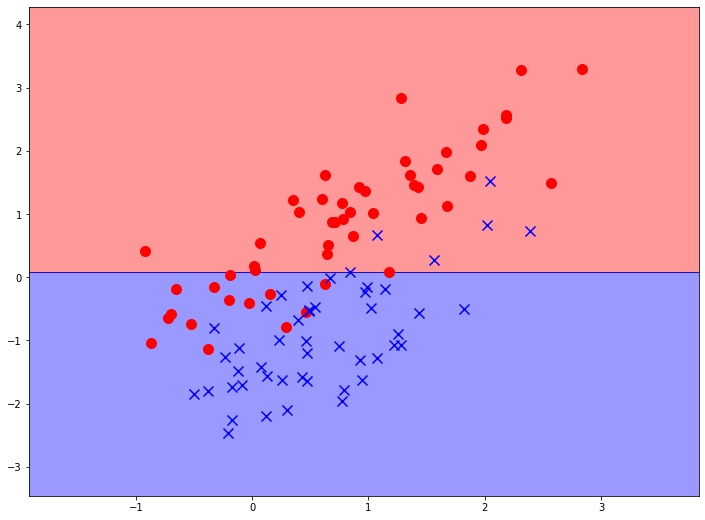

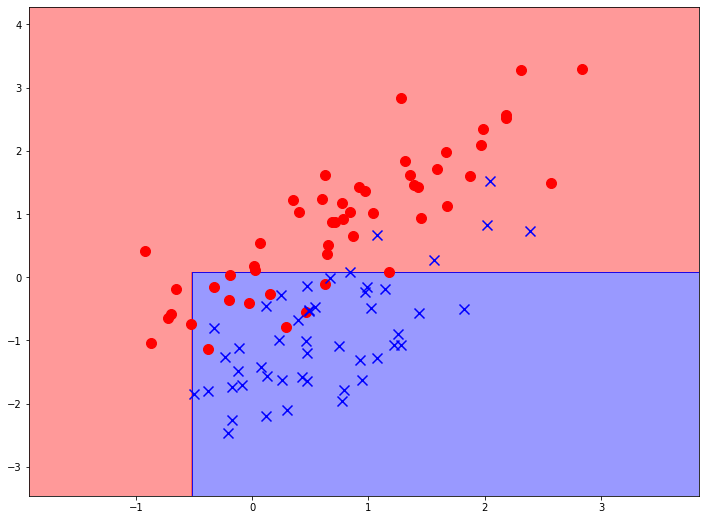

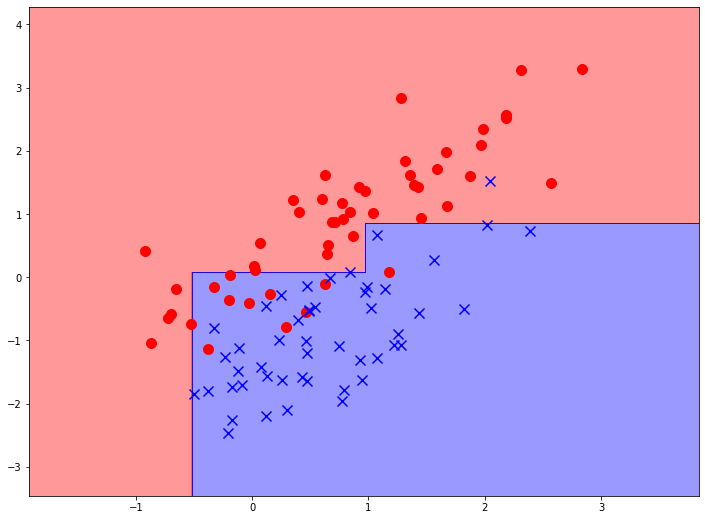

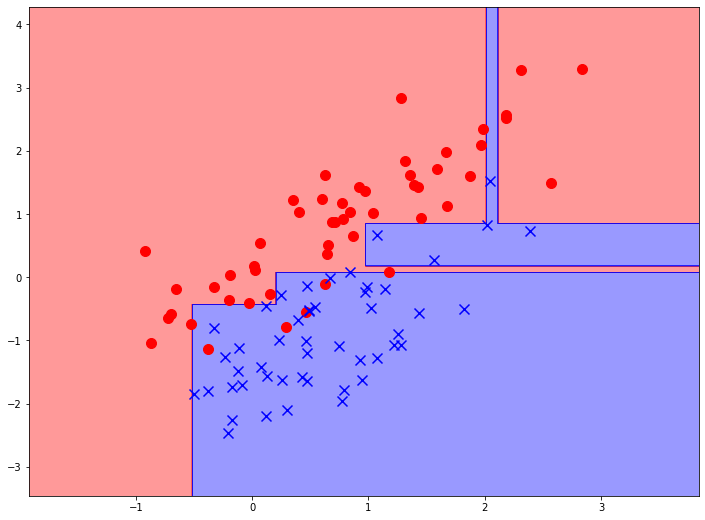

Для построения дерева решений в первую очередь необходимо решить, по какому признаку мы будем разделять выборку. Для этого используются определенные критерии. Чтобы понять, что такое критерий, давайте рассмотри следующую выборку данных для бинарной классификации:

По какому признаку лучше разбить выборку на две части - на отложенному по горизонтально оси (первому) или по вертикальной (второму)? Заметим, что разбиение выборки можно изобразить на графе как пряму линию, перпендикулярную той оси, по которой мы разбиваем. Очевидно, что разбиение по второму признаку (проведение горизонтальной линии) гораздо более целесообразно, ведь в итоге мы получим значительно более однородные подвыборки - в одной будет больше красных объектов, а в другой - синих. Если же мы проведем вертикальную линию, где бы мы ее не провели, две подвыборки будут примерно в равных пропорциях содержать как объекты обоих классов.

Это, конечно, искусственный пример, в котором ответ очевиден. В реальности нам нужен математический механизм, который измеряет, насколько “неоднородными”” станут выборки после разделения по одному из признаков. Для этого чаще всего используются информационная энтропия, вариация или критерий Джини. Рассмотрим наиболее распространенную меру неоднородности выборки для категориальных значений, информационную энтропию:

В данной формуле $s$ - это некоторая выборка, среди элементов которой встречаются $c$ разных значений. $p_i$ - это вероятность (частота) появления значения $i$. Информационная энтропия выборки показывает, насколько неоднородно их распределение. Если разных значений в данной выборке примерно поровну, значение информационной энтропии будет близко к 1, чем чаще будет встречаться одно значение, тем ближе будет значение к 0. Для признаков, измеряемых по числовым, непрерывным шакалам, вместо энтропии используется простая вариация выборки.

Для выбора условия разбиения выборки подсчитывают специальную метрику, называемую прирост информации. Она вычисляется по следующей формуле:

где $d$ - вся выборка, до разделения, $s$ - подвыборка. То есть мы считаем сумму энтропии подвыборок после разделения и сравниваем ее с энтропией исходной выборки. Весь алгоритм нахождения оптимального разбиения сводится к тому, чтобы найти такое разбиение, у которого прирост информации наибольший.

Такой алгоритм способен решать как задачи классификации, так и задачи регрессии. Так как прирост информации вычисляется по распределению именно целевой переменной, в классификационных задачах используется мера энтропии, а в регрессионных - вариация, вот и все различие.

Построение дерева решений - это итеративный процесс, в котором на каждой итерации находится оптимальный признак и его пороговое значение, которое лучше всего разбивает выборку на две подвыборки. Затем процесс повторяется для каждой из двух подвыборок, пока не будет достигнуто некоторое условие остановки алгоритма. Процесс разбиения выборки может окончится двумя способами. Естественный - это когда в выборке остаются объекты только одного из классов. Искусственный - это достижение критерия остановки. В качестве критерия чаще всего используется максимальная глубина дерева. Но можно задать, например, минимально количество объектов в узле.

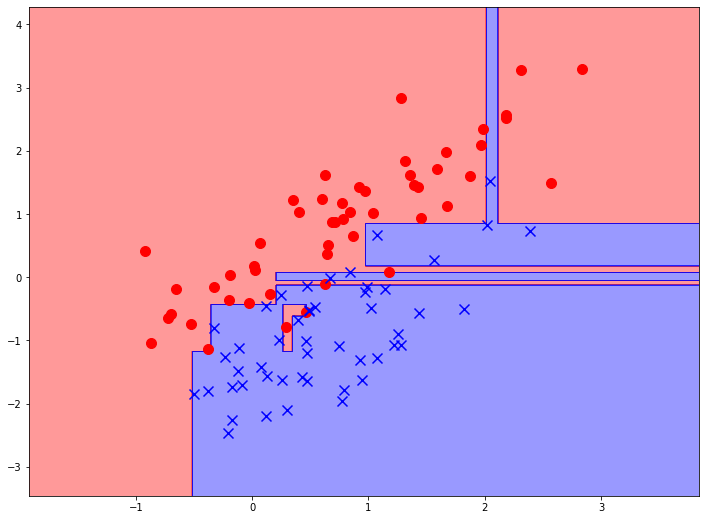

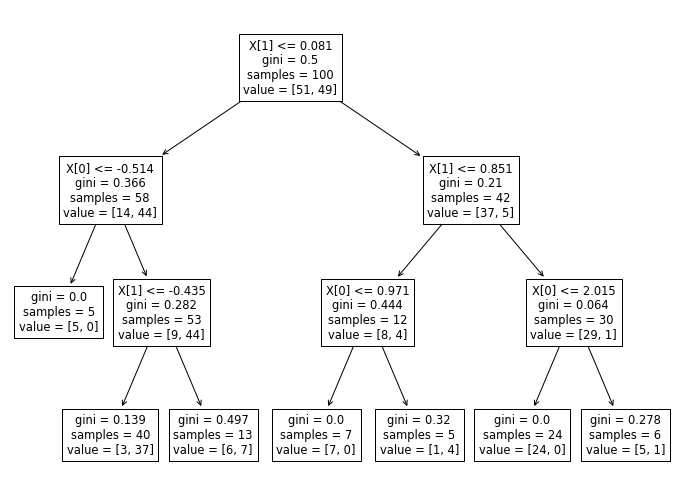

Давайте рассмотрим процесс построения дерева решений на примере простой задачи бинарной классификации. Для использования библиотечной реализации дерева решений нужно всего лишь создать объект соответствующего класса и указать максимальную глубину дерева. Для начала построим дерево глубиной 1 узел:

Мы видим, что модель сделала только одно разделение. Модель выбрала признак, отложенный на вертикальной оси, а также значение этого признака (чуть больше 0), которое максимизирует прирост информации после разделения исходной выборки. Теперь у нас есть две подвыборки (назовем их верхней и нижней), причем ясно видно, что в нижней части заметно больше синих объектов, а в верхней - красных.